story of my life

過去の蓄積を見るために書く日記.

ライトモードとダークモードの切り替えでチラつき解消

2025.11.03

おはようございます.何だか寒い日が続きます、寒いのはあまり好きではないですね….今年の冬は平年よりも寒いかもですね. さて、先日の午前中にこのブログサイトのデザインなどをいじってました.今まであった「文字の大 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

javascript, JS, TypeScript, コード, こちら, こと, サイト, ストレージ, ダーク, タイミング, デザイン, フッター, ブラウザカラー, ブログサイト, ヘッダー, モード, ライド, ローカル, 下記, 不一, 今年, 先日, 切り替え, 制御, 動作, 午前, 参照, 参考, 場合, 変更, 好き, 平年, 微妙, 文字, 明日, 発生, 簡潔, 行間, 解消, 記載, 説明, 読み込み,

AI検索モードで崩壊寸前なのかも、なので.

2025.10.01

おはようございます.あんなにも暑い夏から涼しくなってきましたが冬は平年よりも寒い時期が続くらしいです.冬は好きではないのですが冬が来るのだなって…. さて、AI検索モードで崩壊寸前なのかも、なので何か対策を取 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

AI, API, PC, SEO, アクセス, あんなに, コード, こと, これ, サーバー, サイト, すすめ, ソーシャルメディア, そう, それ, チャット, テコ入れ, どちら, ハウツー, プログラム, ボット, モード, よう, 一番, 人工, 人達, 会社, 処理, 効果, 収入, 収益, 大変, 好き, 安価, 宣伝, 寸前, 対策, 崩壊, 平年, 広告, 当分, 感じ, 打撃, 投稿, 搭載, 改善, 方法, 明らか, 明日, 時代, 時期, 検索, 模索, 激減, 生成, 発信, 直ぐ, 知能, 程度, 自分, 自宅, 覚悟, 記事, 負担, 費用, 開発, 電気, 顧客, 高価,

カラー選択からライトモードとダークモードに切り替えた話

2025.09.22

おはようございます.カラー選択からライトモードとダークモードに切り替えた話を書いています.カラー選択、実は結構自分は気に入っていたのだけどあまり使用されないだろうなぁという思いも前から思っていたのだけど、そのままにしてい […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

```, オペレーション, カラー, ギャラリー, コード, ここ, こと, コメント, ごろ, サービス, システム, スイッチ, ストレージ, ソース, それ, ダーク, チグハグ, テーマ, ところ, ブラウザ, ページ, モード, ライド, ライトモードダークモード, ローカル, ロード, 一つ, 仕様, 以外, 休日, 使用, 保存, 保留, 全て, 切り替え, 初期, 動画, 場合, 変更, 対応, 思い, 明日, 残り, 自分, 視聴, 設定, 課題, 近日, 選択,

人工知能が読みやすいLLMO対策を近日中に対応.

2025.08.31

おはようございます.WordPressに人工知能が読みやすいLLMO対策を近日中に対応を施します.ただ、単にマークダウン記法で出力させるだけなんだけども、そんなに簡単でもないと思います. 簡単といえば簡単?知っているか知 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

コード, こと, これ, コンテキスト, それ, ダウン, ページ, マーク, モード, よう, わけ, 人工, 今後, 出力, 場合, 対応, 対策, 工夫, 恐れ, 打撃, 抽出, 日本, 明日, 時間, 発生, 知能, 確か, 簡単, 脅威, 記事, 記法, 近日,

スターリンクを手元に置いときたいので、スタンバイモードにして置いとこうと

2025.08.22

おはようございます.スターリンクを手元に置いときたいので、スタンバイモードにして置いとこうと思っています.理由は災害時にもネット環境をキープするためにスターリンク衛星は絶対に良い非常ツールだと思うので、スターリンクのキャ […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

インフラ, キープ, キャンペーン, スター, スタンバイ, タイミング, ため, ツール, つもり, ところ, トラフ, ネット, みたい, モード, モバイル, リンク, 今後, 何処, 南海, 地震, 場所, 壊滅, 大丈夫, 巨大, 手元, 明日, 時間, 災害, 理由, 環境, 確実, 絶対, 自分, 衛星, 購入, 込み, 通信, 開放, 限り, 雨雲, 電波, 非常, 高知,

悲報、ググった結果ページに次頁が無くなっている気がしている.たぶん一部のユーザーだけです

2025.08.17

おはようございます.悲報、ググった結果ページに次頁が無くなっている気がしているというタイトル通り、自分のググった結果ページはどうもひと足早くAIモードの表示になっています. 表示の結果を見てこれもうAIで完結するようにな […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

いま, ググ, クリック, こと, これ, サイト, タイトル, ツール, なり, ページ, マスト, モード, よう, 上位, 企業, 多く, 大丈夫, 大手, 完結, 悲報, 打撃, 明日, 検索, 殆ど, 発信, 結果, 自分, 表示, 認知, 通り, 運営, 間違い, 駆使,

ワードプレスのテーブルwp_postsデータを取ってきてLaravelで表示.

2025.07.15

おはようございます.ワードプレスのテーブル(wp_posts)データを取ってきて別サイト(Laravel)にて表示してます.別サイトには広告が付かない感じです.因みにデータは自サイトのブログデータを使用していますが随時去 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

```, ;;⏩, あたり, いん, オート, お伝え, お話, クラス, コード, コア, こと, コネクション, コントローラー, コンフィグフォルダ, サイト, シェア, スクリプト, その他, それら, ダーク, データ, データベース, テーブル, ドップ, ヒント, ファイル, フラグ, ブレイド, プレス, ブログデータ, ボタン, モード, モデル, もの, よう, リンク, ローダ, ワード, 付与, 作成, 使用, 処理, 出力, 切り替え, 去年, 取得, 変更, 広告, 感じ, 明日, 明記, 流石, 簡単, 表示, 要素, 言語, 記述, 設定, 選択, 随時,

目が覚めてから大体1時間ぐらいPCを付けてぼーっとしている時間がある

2025.06.27

おはようございます.昨日はデススト2の発売日でした、まだ購入はしていません. さて自分には目が覚めてから大体1時間ぐらいPCを付けてぼーっとしている時間がある、だいぶ前からだけど目が覚めてはいるけど、脳が回転していない時 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

あと, それ, タスク, デススト, ブログ, メリット, モード, よう, リズム, リモート, ワーク, 事柄, 仕事, 以上, 使い道, 回転, 基本, 大体, 影響, 感じ, 散歩, 早朝, 明日, 昨日, 時間, 普及, 朝食, 消化, 特権, 発売, 睡眠, 経過, 自分, 自動, 購入, 通勤, 通常, 運転,

AIで記事を学習して新たな記事を生み出すにはお金が必要だと思っていたがそうでも.

2025.06.22

おはようございます.AIで記事を学習して新たな記事を生み出すにはお金が必要だと思っていたがそうでもなくローカルPCでそこら辺に落ちているLlamaモデルを持ってきてチューニングすれば何とかなるじゃねぇという思いに至った. […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

```, ;;), )。, アウト, アシスタント, アダプター, あたり, アップ, あなた, いくつ, ウォーム, エポック, エラー, エントリ, オープン, オプティマイザ, お金, クラウドサービス, グループ, クン, ゲーミング, コード, コア, ここ, こと, コミュニティ, コメント, これ, サイズ, サンプリング, サンプル, シーケンス, スクリプト, スケーリング, スケジューラー, スタイル, ステップ, スペック, すべて, ソース, そこら, タイプ, ダウンロード, タスク, ため, チューニング, ツール, データ, データセット, テーマ, ディレクトリ, テキスト, デバイス, デフォルト, トー, トークナイザー, とき, どれ, トレーナー, ドロップ, バイアス, パス, バッチ, パディング, パラメータ, バランス, ファイル, ファイルサイズ, ファインチューニング, ファインチューニングコード, フリーズ, プロ, プロンプト, マシン, マッピング, メモリ, モード, モデル, もの, ユーザー, よう, ライター, ライブラリ, ラベル, ランク, リモート, レベル, レポート, ローカル, ロード, ログ, 一般, 一部, 上記, 不要, 世界, 世界中, 並み, 並列, 予算, 付与, 以下, 以降, 企業, 使い, 使用, 係数, 保存, 個人, 優秀, 入力, 公開, 共有, 具体, 処理, 出力, 分割, 分散, 分野, 初期, 利点, 利用, 制御, 削減, 削除, 創造, 加速, 助け, 効率, 動作, 勾配, 十分, 参考, 反映, 可能, 向上, 味方, 因果, 場合, 多様, 夢物語, 大幅, 大量, 失敗, 学習, 完了, 完全, 完璧, 実現, 実行, 実質, 寄与, 対応, 専門, 導入, 少量, 工夫, 希望, 常識, 強力, 形式, 必要, 思い, 性能, 手元, 手法, 技術, 抜群, 指定, 指示, 挿入, 推奨, 推論, 提供, 整形, 新た, 方法, 日々, 明日, 明確, 明示, 時代, 時間, 最大, 最新, 最適, 有効, 未知数, 本格, 格段, 格納, 構築, 様々, 比率, 民主, 活用, 活発, 消費, 混合, 済み, 温度, 準備, 無効, 無料, 特定, 特権, 現実, 理由, 環境, 生成, 発生, 登場, 的確, 相性, 短時間, 確認, 秘訣, 移動, 程度, 管理, 節約, 精度, 終了, 結合, 結果, 続行, 能力, 自体, 自分, 自動的, 蓄積, 表現, 言語, 計算, 記事, 設定, 許可, 調整, 費用, 軽量, 追加, 通常, 適用, 選択, 重み, 重要, 量子, 開始, 開発, 関数, 閾値, 非常, 高速, 高額, 魅力,

映画、ムーンフォールを観ましたので感想を残しときます。

2022.07.31

おはようございます。朝方にかけてどしゃ降りになりましたね。 さて昨日、ムーンフォールを観ましたので感想を残しときます。この映画、月の真実を知った時にその想定を受け止めれるかどうかで、大きく観た印象が異なると思っています。 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

SF, Vr, アクション, おすすめ, オチ, かなり, こと, ストーリー, どしゃ降り, ニヤ, パニック, フォール, ムーン, モード, 一, 一つ, 一貫, 予告, 予測, 何, 作り, 使用, 倍速, 分かれ道, 印象, 大体, 展開, 想定, 感想, 所, 手, 映画, 昨日, 時, 最初, 最後, 月, 朝方, 王道, 画面, 目, 真実, 等, 自分, 評価,

先日のau通信障害。今も続いていたら悲惨だな。

2022.07.05

おはようございます。通信障害は改善されたでしょうか。 復旧されていない場合もこのまま投稿タイトルで、記載していきます。因みに通信障害一日目の夜に夜な夜なデスクトップに向かって一週間分の予約投稿記事を書いていたりします。こ […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

au, OFFON, オフライン, お昼, お金, このまま, これ, タイトル, データ, デスクトップ, ところ, モード, 一, 一定, 不便, 予定, 予約, 今, 今日, 仕事, 保持, 先日, 其処ら, 出社, 土曜日, 場合, 夕方, 夜, 大変, 帰宅, 復旧, 悲惨, 投稿, 改善, 時, 機内, 決済, 火曜日, 為, 状態, 直行, 自分, 記事, 記載, 財布, 辺, 通信, 金額, 障害, 電子,

千年女優という映画を倍速モードで観ました。つま・・・なかった。

2022.06.10

おはようございます。PGフリーランスの案件は結構高額が多い訳はお国が20%ピンハネするからです? 課税される所得金額税率控除額195万円以下5%0円195万円超330万円以下10%97,500円330万円超695万円以下 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

0, 000, 1, 10, 153, 195, 20, 23, 279, 33, 330, 4, 40, 42, 45, 479, 5, 500, 6, 63, 695, 7, 800, 900, 97, Netflix, PG, RSS, アニメ, これ, つま, ところ, トップガン, ピンはね, フリー, モード, ランス, レトロ, 万, 人, 倍速, 先日, 千, 国, 女優, 少し, 感性, 所得, 控除, 映画, 昭和, 普通, 最新作, 案件, 目, 税率, 結局, 訳, 評判, 課税, 途中, 金額, 高額,

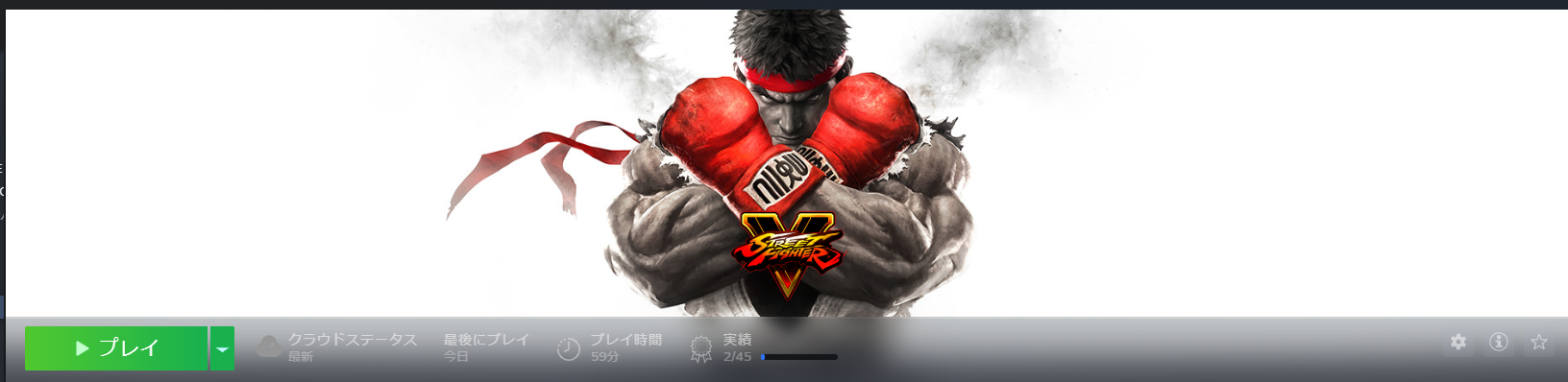

ストリートファイターVを購入しましたよ。1990円で?

2022.05.27

おはようございます。 先日の日曜日の朝、Twitterのタイムライン、通称TLにストリートファイターVが1990円で購入できるよというものが流れてきたので、Steamで購入しました。いま、Steamではpaypay決済も […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

1990, Paypay, STEAM, tL, Twitter, イージー, いま, ゲーマー, コンピューター, ストリート, ストレス, タイムライン, テトリス, ファイター, プロ, ボコボコ, ぽち, モード, もの, りま, 不器用, 久々, 人, 便利, 先日, 内容, 割愛, 合間, 感, 感じ, 感覚, 日曜日, 時間, 朝, 決済, 発散, 自分, 購入, 通称,

英字配列のキーボードに鞍替えしました。それとネットフリックスも。

2021.12.14

今までエレコムのキーボードを使用していたのです、安い割には打ちやすいキーボードでしたが一つ難点といえば、マウス操作時にキーボードにマウスがよくあたるという問題がありました。その問題が結構嫌だったので、思い切って英字配列の […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

{}, Windows, エレコム, キーボード, これ, コンパクト, それ, つもり, ネットフリックス, プログラミング, マウス, モード, もう一つ, もの, レベル, 一つ, 事, 人, 今, 仕事, 使用, 割, 問題, 場合, 変更, 少し, 我慢, 打鍵, 操作, 時, 気, 理由, 職場, 自分, 英字, 解消, 設定, 購入, 配列, 難点, 静音, 鞍替え,

wifi中継機とルーターのブリッジモードの違いを知らずに散財した過去?

2021.08.09

髪の毛がたいぶ伸びてきて、うざく感じるようになってきたので来週には床屋さんに行きたいなと思っているのですが、何せ無収入?なので出費がヤダなと思っています。 さてwifi中継機とルーターのブリッジモードの違いを知らずに散財 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

DHCP, LAN, wifi, イブ, インターネッ, インターネット, ガタ, ケーブル, こと, それ, ブリッジ, モード, リンク, ルーター, ワザ, 一, 中継機, 二, 使用, 優先, 出費, 収入, 可能, 同士, 場合, 子, 床屋, 思い出, 接続, 散財, 昔, 来週, 機能, 簡単, 結果, 親, 話, 購入, 通信, 過去, 違い, 駄目, 髪の毛,

FF7Rがやっと。

2020.12.02

FF7Rがやっとチャプター14に行き着きました。あと、もう少しでFF7Rの1stが終わろうとしています。来年にはFF7Rの1stのエンディング?が見えると思います。 まだFF7Rをプレイしていない方、プレイしてみようと思 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

1, 14, 16, 5, 7, FF, PS, st, youtube, いち, エンディング, かな, かなり, クラッシック, クリア, ゲー, こと, サイト, タイトル, チャプター, とき, プレイ, まえ, モード, 先, 公式, 動画, 半減, 方, 最後, 未だ, 来年, 楽しみ, 気, 発売, 続編, 自分, 話,

FF7RのDEMOをプレイしてみて。

2020.03.03

FF7RのDEMOをプレイしてみて思った。これは期待以上の仕上がりです、凄すぎる映像がリアルです、そして戦闘シーンも超リアル感がある、クラシックモードでも楽しめるしこれはとても良い。今までの歴代ファイナルファンタジーの中 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

1, 7, demo, FF, REMAKE, かなり, クラシック, これ, シーン, シェア, ダントツ, ファイナルファンタジー, ファミ通, プレイ, モード, リアル, リメイク, リリース, 中, 動画, 応用, 感, 戦闘, 技術, 映像, 時間, 最後, 期待, 次期, 歴代, 画像, 群, 自分, 開発,

R-PlayアプリでPS4用リモートプレイが外出先でも出来ちゃう神アプリ!

2020.01.21

R-PlayアプリでPS4用リモートプレイが外出先でも出来ちゃう神アプリがios用にあります。これはとても良い感じがしますがセキュリティの事が心配という方は公式アプリが外出先に対応するまで待つかプレイステーションVITA […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

1400, 4, DMZ, iOS, IP, PS, R-Play, VITA, アドレス, アプリ, おすすめ, これ, セキュリティ, それ, ため, ネットワーク, ブリッジ, プレイ, プレイステーション, ポート, モード, モデム, もの, リモート, ルーター, 中古, 事, 人, 公式, 兼, 固定, 地帯, 場合, 変更, 外出, 対応, 心配, 必要, 感じ, 方, 有料, 機器, 機能, 武装, 用, 神, 設定, 購入, 開放,

指定時間になったら自動的に復帰(スリープ/休止状態)

2015.11.18

上記のコマンドで指定時間になったら自動的に復帰(スリープ/休止状態)する 事ができます。ちなみに3600とは3600秒(1時間後)という意味です。 menはスリープ状態を指し、diskはサスペンドを指します。 スリープ状 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が30代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

```, -m, -s, -t, 06, 1, 11, 18, 2015, 30, 3600, D-, date, disk, mem, men, quot, rtcwake, こと, コマンド, サーバー, サスペンド, スリープ, パソコン, ボタン, モード, ローカル, 上記, 事, 休止, 余計, 帯, 平日, 復帰, 必要, 意味, 指定, 時間, 注意, 状態, 節約, 自分, 起動, 電力, 電気, 電源,