story of my life

過去の蓄積を見るために書く日記.

ポップアートと生成AIとAIで思ったこと.

2025.12.25

おはようございます、ポップアートを生成AIと共にAI(イラレ)で作ることが楽しいのですが、実際は自分で一から作りたいなという思いがあります. 自然言語で指示すればそれなりのモノがイラレでも出力されるようになってきました. […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

AI, イラレ, クリエイター, クリエイティブ, コード, こと, これ, サン, そう, それ, それなり, とき, ところ, ナノ, バナナ, フォトショ, プロ, ポップアート, もの, よう, 一番, 一部, 人間, 作品, 使用, 修正, 出力, 問題, 境界, 売れっ子, 完璧, 思い, 感じ, 成果, 技術, 指示, 明日, 時代, 最新, 状況, 生成, 精度, 素人, 脅威, 自分, 自然, 言語, 面白み,

AI技術のRAG (Retrieval-Augmented Generation: 検索拡張生成)

2025.12.03

おはようございます.AI技術のRAG (Retrieval-Augmented Generation: 検索拡張生成)をこのブログに取り入れることは可能かも知れないなと思っています.出来たら面白いかも知れないけど、ちょっ […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

AI, ChatGPT, Dify, GENERATION, ID, Python, RAG, RetrievalAugmented, VPS, あと, あれ, おすすめ, コード, ここら, こと, これら, コンテキスト, サーバー, スペック, そう, それ, タグ, ディファイ, ノー, プレス, ブログ, マシン, モデル, もの, よう, ラク, レコメンド, レコメンドアルゴリズム, ワールド, 予測, 使用, 傾向, 出現, 前提, 可能, 学習, 完璧, 導入, 必要, 感じ, 技術, 拡張, 数値, 明日, 時代, 時間, 最高, 条件, 検索, 機械, 物理, 環境, 生成, 自分, 記事,

制限付きのクロンを無限寿限無にする方法改正版

2025.11.15

おはようございます.以前作ったコードを改修して、いまの自分が書いたらどうなるのだろうかと思って書いたコードをQiitaとGithubにアップしました.書いてみて思ったのは、やはりコードは書けば書くほど進化していくのだなと […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

AI, github, https, qiita, zipcomebeebbedeaeeafeadebeeaeeafbfeeaeabeebebebephpeahtml, アップ, いま, お墨付き, コード, こちら, こと, これ, コレ, ソース, そう, ため, よう, 今回, 今後, 仕事, 以前, 使用, 典型, 完璧, 改修, 明日, 毎日, 洗練, 精進, 自分, 記事, 進化, 過去,

映画、沈黙のパレードを観ました.人間模様がね.

2025.09.18

おはようございます.先日の休みにネットフリックスで映画、沈黙のパレードを観ました(今頃観ました).まぁざっくり感想を書くとすると人間模様がね所ですね. 人ってちょっとした事で間違った方向へ行ってしまったりしますからね、大 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

こと, ストーリー, そう, なり, ネットフリックス, パレード, ほう, みたい, 人生, 人間, 今回, 今頃, 休み, 先日, 原作, 司法, 圭吾, 執着, 嫉妬, 完璧, 小説, 展開, 弱者, 思い, 思い違い, 感想, 方向, 明日, 映画, 東野, 模様, 沈黙, 流れ, 社会, 自分, 読み応え, 限界, 面白味,

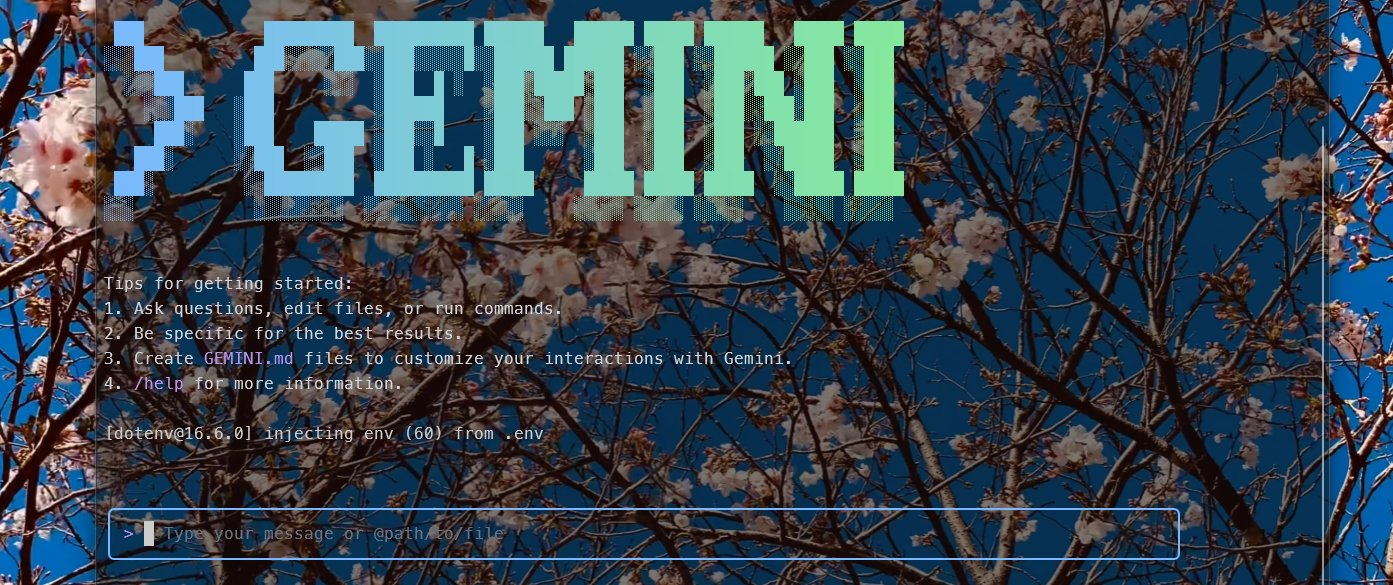

Gemini CLIのコマンド一覧集の日本語に翻訳したものを置いときます.v0.1.15

2025.08.05

おはようございます.Gemini CLIのコマンド一覧集の日本語に翻訳したものを置いときます.バージョンは0.1.15になります.それなりにエックスにポストしてビュー数が多かったので需要があるかなと思ってブログ記事にしま […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

(:, エックス, コード, こと, コマンド, これ, そう, それ, それなり, テック, ところ, バージョン, バイブコーディング, ビュー, ブログ, ポスト, もの, よう, 一覧, 世の中, 人工, 仕事, 企業, 便利, 修正, 出力, 土台, 好き, 完璧, 対価, 巨人, 引き換え, 情報, 感じ, 指示, 提供, 摂取, 日本語, 明日, 時代, 最後, 最終, 瞬時, 知能, 確か, 答え, 翻訳, 自分, 記事, 質問, 需要,

AIで記事を学習して新たな記事を生み出すにはお金が必要だと思っていたがそうでも.

2025.06.22

おはようございます.AIで記事を学習して新たな記事を生み出すにはお金が必要だと思っていたがそうでもなくローカルPCでそこら辺に落ちているLlamaモデルを持ってきてチューニングすれば何とかなるじゃねぇという思いに至った. […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

```, ;;), )。, アウト, アシスタント, アダプター, あたり, アップ, あなた, いくつ, ウォーム, エポック, エラー, エントリ, オープン, オプティマイザ, お金, クラウドサービス, グループ, クン, ゲーミング, コード, コア, ここ, こと, コミュニティ, コメント, これ, サイズ, サンプリング, サンプル, シーケンス, スクリプト, スケーリング, スケジューラー, スタイル, ステップ, スペック, すべて, ソース, そこら, タイプ, ダウンロード, タスク, ため, チューニング, ツール, データ, データセット, テーマ, ディレクトリ, テキスト, デバイス, デフォルト, トー, トークナイザー, とき, どれ, トレーナー, ドロップ, バイアス, パス, バッチ, パディング, パラメータ, バランス, ファイル, ファイルサイズ, ファインチューニング, ファインチューニングコード, フリーズ, プロ, プロンプト, マシン, マッピング, メモリ, モード, モデル, もの, ユーザー, よう, ライター, ライブラリ, ラベル, ランク, リモート, レベル, レポート, ローカル, ロード, ログ, 一般, 一部, 上記, 不要, 世界, 世界中, 並み, 並列, 予算, 付与, 以下, 以降, 企業, 使い, 使用, 係数, 保存, 個人, 優秀, 入力, 公開, 共有, 具体, 処理, 出力, 分割, 分散, 分野, 初期, 利点, 利用, 制御, 削減, 削除, 創造, 加速, 助け, 効率, 動作, 勾配, 十分, 参考, 反映, 可能, 向上, 味方, 因果, 場合, 多様, 夢物語, 大幅, 大量, 失敗, 学習, 完了, 完全, 完璧, 実現, 実行, 実質, 寄与, 対応, 専門, 導入, 少量, 工夫, 希望, 常識, 強力, 形式, 必要, 思い, 性能, 手元, 手法, 技術, 抜群, 指定, 指示, 挿入, 推奨, 推論, 提供, 整形, 新た, 方法, 日々, 明日, 明確, 明示, 時代, 時間, 最大, 最新, 最適, 有効, 未知数, 本格, 格段, 格納, 構築, 様々, 比率, 民主, 活用, 活発, 消費, 混合, 済み, 温度, 準備, 無効, 無料, 特定, 特権, 現実, 理由, 環境, 生成, 発生, 登場, 的確, 相性, 短時間, 確認, 秘訣, 移動, 程度, 管理, 節約, 精度, 終了, 結合, 結果, 続行, 能力, 自体, 自分, 自動的, 蓄積, 表現, 言語, 計算, 記事, 設定, 許可, 調整, 費用, 軽量, 追加, 通常, 適用, 選択, 重み, 重要, 量子, 開始, 開発, 関数, 閾値, 非常, 高速, 高額, 魅力,

映画、そして、バトンは渡されたを観ました。 #ネトフリ #映画 #Netflix

2022.11.23

おはようございます、水曜日の朝ですね、書いているのは月曜日の朝です。 今日は映画を一本観ましたのでその感想を書いていきます。本日、観た映画は「そして、バトンは渡された」です。劇場で観えなかったのでやっと観えたなって感じで […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

2, 4, 95, com, fKypJ, https, Netflix, watch, www, youtube, あと, これ, すね, ネタ, ネトフリ, バトン, バレ, ホント, もの, 一, 一言, 予告, 事, 今日, 劇場, 原作, 女性, 完璧, 小説, 尽, 度, 感動, 感想, 映画, 映画館, 月曜日, 朝, 本日, 水曜日, 理由, 自分, 足, 順番,

トラックボールマウスを購入しました、もはや帰れない。

2022.03.18

おはよう御座います。もう春ですね🌴。日本は春の次に梅雨という時季があります、早く梅雨の時季が過ぎ去りますようにと今から思っています😏。 トラックボールマウスを購入しました、悩んだあげく手が勝手にポッチっていました。勝手良 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

あげく, イラ, キーボード, こちら, こと, それ, ため, デスク, トラック, トラックボ, ふい, ボール, ポインタ, ポッチ, マウス, ワーク, 一度, 中, 事, 今, 仕事, 会社, 便利, 勝手, 問題, 完璧, 対策, 小型, 手, 操作, 方, 日本, 春, 時季, 梅雨, 次, 正解, 理由, 結果, 肩こり, 腰痛, 自分, 解消, 購入,

映画、マトリックス・レザレクションズ、やっぱ今日観に行きます(AM11時)! #マトリックス

2021.12.17

映画、マトリックス・レザレクションズを本日、11時に始まる字幕版を観に行きます?、感想につきましては映画を見終わった後に、ネタバレなしでツイートします。日本語版の方が上映数が多いのは少し残念ですね。 マトリックス三部作の […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

11, AM, com, https, mBRWwAqJ--U, watch, www, youtube, キアヌリーブス, こと, ストーリー, スローモーション, タイム, ツイート, バレット, マトリックス, レザレクションズ, 三部作, 上映, 世界観, 中, 予告, 今, 今回, 今日, 前回, 字幕, 完璧, 少し, 展開, 後, 感想, 撮影, 新章, 方, 方法, 日本語版, 映像, 映画, 本日, 楽しみ, 残念, 気, 観, 限り,

日進月歩でCertbotのインストール仕方が変わっていた話。

2021.07.26

オリンピックの冒頭の音楽がいじめ問題で差し変わるらしいという話を聞きました。この記事が投稿される時にはオリンピック開会式は終わっている頃ですが・・・?。どうなったでしょうか、気になります。もし完璧な状態でオリンピック開催 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

3, Certbot, install, snap, SSL, yum, インストール, オリンピック, コマンド, ツイート, ブラック, プロフェッショナル, もの, 事, 仕方, 仕様, 件, 先日, 冒頭, 問題, 変更, 完璧, 対応, 投稿, 日進月歩, 映像, 時, 案件, 気, 状態, 環境, 簡単, 記事, 話, 開会式, 開催, 音楽, 頃, 駄目,

完璧に作らず運用しながら改善するのがベストかも。

2021.04.15

今、カートシステムを作っているのだけど完璧に作らず運用しながら改善するつもりでいます。サブスクとして運用していくつもりで、980円か売上の何パーセントかをピンはねする様にします。カートシステムなんてありふれているので、収 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

980, API, Pay, url, お客様, カード, クレジット, サブ, システム, スク, つもり, データ, パーセント, ピンはね, ベスト, メール, 不具合, 不明, 事, 今, 代引き, 何, 何度, 再来月, 収益性, 可能性, 完璧, 導入, 少し, 形, 意味, 振込, 改善, 最初, 末, 決済, 無料, 申請, 自分, 請求, 運営, 運用, 部分, 銀行, 開発, 順調, 頓挫,

text形式に土日は変更。

2020.10.03

土日は基本テストスタイルに変更しようと思っています。なお、今まで土日はイラストを挿絵としていれておりましたが、サーバー移行の際に画像データがすべて消えてしまったことにより、この際、テキスト形式にしようと思ったので、そのよ […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

567, Text, イラスト, お休み, お話, こと, サーバー, スタイル, すべて, データ, テキスト, テスト, リスク, 予告, 事, 土日, 基本, 場合, 変更, 完璧, 密室, 形式, 感動, 挿絵, 映画, 映画館, 本当, 本数, 本日, 気, 気持ち, 浅田家, 画像, 短文, 移行, 空調, 結構, 記事, 設備, 際, 高知県,

質問DATA検索を作りました。

2020.08.29

質問箱というサービスでじぶんに質問してくれる方がいます、そんな人達が使用してくれればなと思い、ちょこちょこっと作りました。OR検索はできません。ワンキーワードだけの検索ですが、役に立つかなと。 じぶんは重複した(似たよう […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

1, data, OR, url, いち, ウェブ, キーワード, グラム, コード, こちら, こと, コピペ, サービス, サイト, じぶん, ちょこ, データ, プロ, プログラム, もの, ワン, 人, 仕様, 何度か, 使用, 回答, 完璧, 役, 手動, 方, 検索, 汎用性, 登録, 簡単, 質問, 過去, 重複, 長年,

夜な夜なサーバー移行。

2020.06.27

夜な夜なサーバー移行。ほぼ徹夜してサーバー移行を行いました。ちょっとは表示速度が早くなったかな?、どうだろうか。よくわからないけど・・・。当分、このサーバーを使用していこうと思います。何故かわからないけどブログが表示され […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

サーバー, ちょっと, ブログ, わけ, 使用, 全部, 半分, 完璧, 徹夜, 悪戦苦闘, 感じ, 所, 正直, 移行, 結構, 自分, 表示, 途中, 速度,

AutoML-Zeroで妄想。

2020.04.21

AutoML-Zeroで妄想してみました。AutoML-Zeroというのはグーグルさんが作った自ら進化するAI(人工知能)の事を指します。何がすごいってコーディングされたものを自ら最適化するところです。これって有ることに […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

AI, AutoML-Zero, いま, グーグル, コーディング, こと, これ, それ, ため, ところ, ひとと, もの, ロボット, 事, 人, 人工, 人形, 何, 何故, 創造, 妄想, 完璧, 差, 想像, 感情, 技術, 時, 暴走, 最適化, 有機, 模倣, 気, 無機, 物質, 現在, 疑問, 発展, 知能, 自ら, 設計, 進化, 違い, 電池, 食物,

きっと無人化進む今後10年以内に。

2019.12.19

日本でもきっと無人化進む今後10年以内と思っている。何故なら人口減少の時代になるから、そして外国人労働者に投資するより長期的にみるとコストダウンだから無人化は進むと思います。 最初はアシスト要因としていたスタッフも最終的 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が30代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

10, 20, アシスト, ゲー, コスト, これ, コンビニ, スーパー, スタッフ, ダウン, 世, 中, 人口, 今後, 労働者, 可能, 外国人, 完璧, 後期, 打破, 投資, 方, 日本, 時代, 最初, 未来, 減少, 無人, 現実, 発展, 目, 社会, 若者, 要因, 高齢者,

英語を止めて中国語を勉強なさい。

2019.12.09

https://www.lingq.com/ja/ 20ヶ国語話せるおじいさん…。凄いな・・・日本人が聞いても理解できるから凄いな。 たぶん、日本人は完璧な英語が喋りたいから、挫折するだろうなと感じます。伝わらないと日本 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が30代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

0, 1, 20, 4, com, UlCz, youtube, おじいさん, おすすめ, こと, それ, 一, 下記, 中国語, 何, 何度, 割合, 勉強, 動画, 場合, 完璧, 挫折, 方法, 日本人, 映画, 最初, 理解, 確率, 程度, 結構, 能力, 自分, 英単語, 英語, 語, 途中, 障壁,

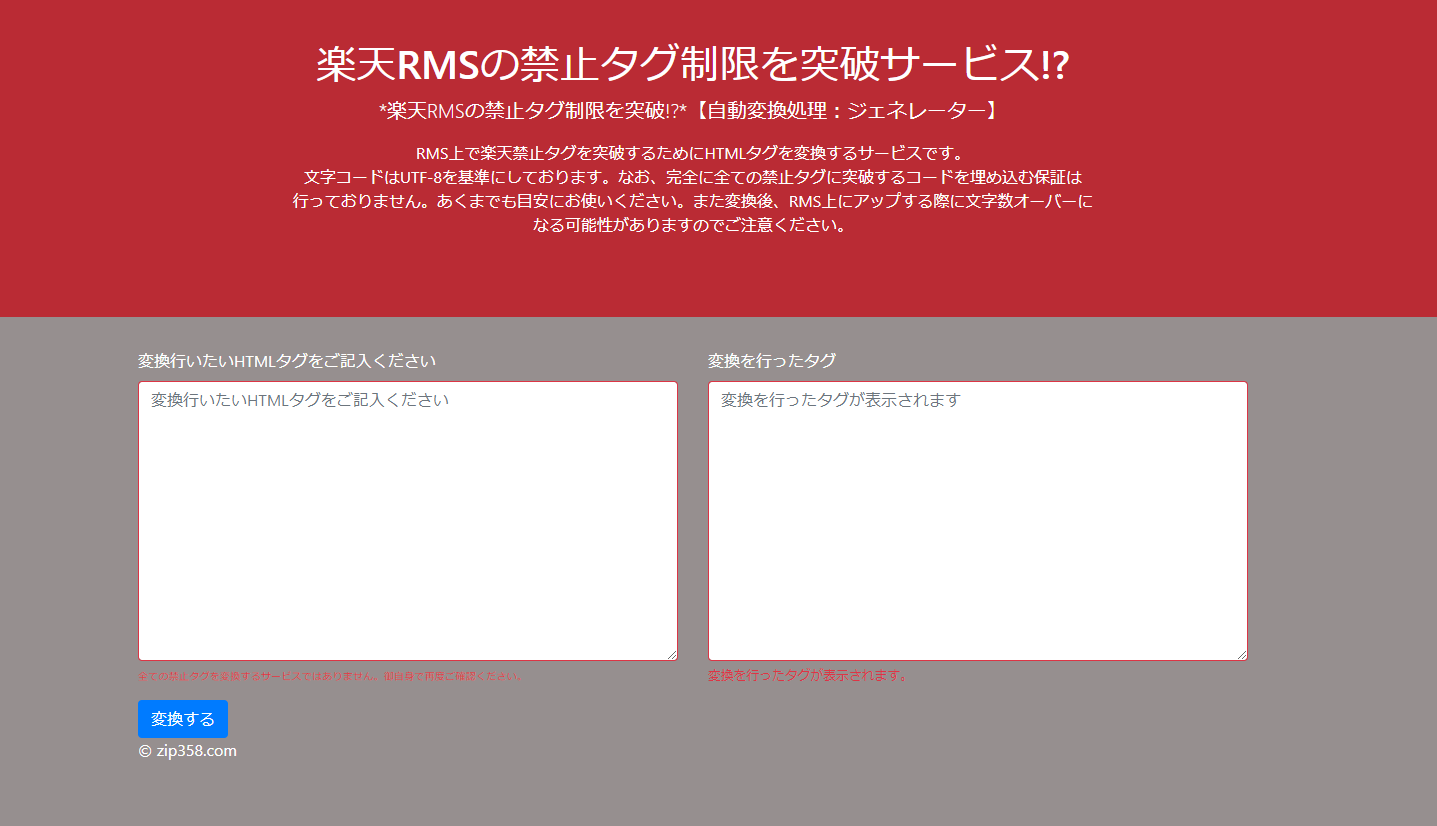

楽天RMSの禁止タグ制限を突破サービス!?

2019.09.07

楽天RMSの禁止タグ制限を突破サービスを自前してみました。完璧ではないけど需要はあると思いますのでリリース、ちなみにこちらのソースコードは非公開とさせて頂きます。※会社でも似たような機能開発していますから…。自分の頭の中 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が30代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

358, Chrome, com, https, nbsp, PC, rakuten-RMS-tag, RMS, tool, www, zip, お使い, コード, こちら, ご飯, サービス, ソース, タグ, ブラウザ, モバイル, リリース, リンク, 中, 会社, 公開, 制限, 完璧, 対応, 工場, 広告, 意識, 推奨, 操作, 最新, 楽天, 機能, 禁止, 突破, 自分, 自前, 設計, 開発, 需要, 頭,

Gitサーバを構築するという事になり。

2016.01.04

大晦日から元旦かけて、会社でGitサーバを構築するいう事になり勉強をしていました。Gitサーバを立ち上げようと発案したのは自分、じぶんが発案者なので勉強するのも道理だろうとGitサーバを勉強しました。結論から言えば出来た […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が30代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

-y, auto, branch, color, config, diff, false, git, global, install, Mac, quotepath, status, Windows, yum, いまいち, ウソ, うち, サーバ, じぶん, 事, 会社, 元旦, 勉強, 大晦日, 完璧, 掲載, 方法, 構築, 理屈, 発案, 発案者, 結論, 自分, 話, 道理,

cronの設定数に制限があるさくらサーバーとかで制限以上に使う方法(´Д`)

2015.01.12

cronの設定数に制限があるさくらサーバーとかで制限数以上(cron設定を増やす方法 )に使う方法はないかなと考えた結果、自分はこうしました。 一つのPHPファイル(実行ファイル)から複数のファイルをキックすることに!( […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が30代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

3, Asia, cron, date, ini, php, shell, timezone, Tokyo, いの, キック, こと, サーバー, さくら, ゾーン, タイム, パス, ファイル, ヘタ, ボツ, メソッド, レンタル, わけ, 一つ, 人, 人間, 処理, 制作, 制限, 場合, 完璧, 実行, 後, 成功, 方法, 無理, 結果, 考え方, 自分, 複数, 複数個, 設定, 追加,