story of my life

過去の蓄積を見るために書く日記.

メディアライブラリにメディアをコピペ保存出来るプラグイン

2026.01.16

おはようございます.メディアライブラリにメディアをコピペ保存出来るプラグインを作りました.メディアライブラリの項目を開きコントロール+V(ペースト)する事でコピーしたメディアをメディアライブラリに保存できるプラグインです […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

AI, github, アイキャッチ, いん, お裾分け, クリップ, クローン, コード, コピー, コピペ, コントロール, それ, フラグ, ブログ, ペースト, ボード, メディア, ライブラリ, 保存, 対応, 手間, 明日, 生成, 画像, 記事, 項目,

セキュリティが甘いサイト

2026.01.05

おはようございます.去年の暮れにXにポストした内容を書いていきます.おせち料理を去年の11月に頼んだサイトがあるのですが、このサイトの会員ページがズタボロ感が強かったので不安を覚えました. 不安を覚えたので、サイトのフロ […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

ID, pass, クッキー, コード, こと, サーバー, サイト, ズタボロ, セッション, ソース, それ, データベース, ハイジャック, フロント, ページ, ポスト, よう, 不安, 今どき, 会員, 保存, 入手, 内容, 去年, 参照, 可能, 基本, 場合, 平文, 情報, 料理, 明日, 暮れ, 流出, 番号, 登録, 確か, 脆弱, 退会, 違和感, 電話, 非常,

noteというサービスに移行しづらいです.

2025.11.02

先日、絵日誌はNoteに開設したというお話を先日したと思いますが、このブログもnoteというサービスに移行(ワードプレスから)しようと以前試してみました.結果、結論から言うとインポートした記事が全部下書き保存になってしま […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

note, いま, いん, お話, ゲー, こちら, こと, これ, サービス, スタンス, そう, そこ, それ, それなり, どこ, ビュー, プレス, ブログ, ポート, ぽち, もの, ワード, 一括, 下書き, 以前, 保存, 先日, 全部, 公開, 収益, 広告, 微妙, 手動, 手段, 拡張, 断念, 日誌, 明日, 時点, 未定, 来年, 機能, 正直, 毎日, 無理, 生産, 移行, 結果, 結論, 自作, 要素, 記事, 追伸, 途中, 開設, 限り, 魅力,

カラー選択からライトモードとダークモードに切り替えた話

2025.09.22

おはようございます.カラー選択からライトモードとダークモードに切り替えた話を書いています.カラー選択、実は結構自分は気に入っていたのだけどあまり使用されないだろうなぁという思いも前から思っていたのだけど、そのままにしてい […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

```, オペレーション, カラー, ギャラリー, コード, ここ, こと, コメント, ごろ, サービス, システム, スイッチ, ストレージ, ソース, それ, ダーク, チグハグ, テーマ, ところ, ブラウザ, ページ, モード, ライド, ライトモードダークモード, ローカル, ロード, 一つ, 仕様, 以外, 休日, 使用, 保存, 保留, 全て, 切り替え, 初期, 動画, 場合, 変更, 対応, 思い, 明日, 残り, 自分, 視聴, 設定, 課題, 近日, 選択,

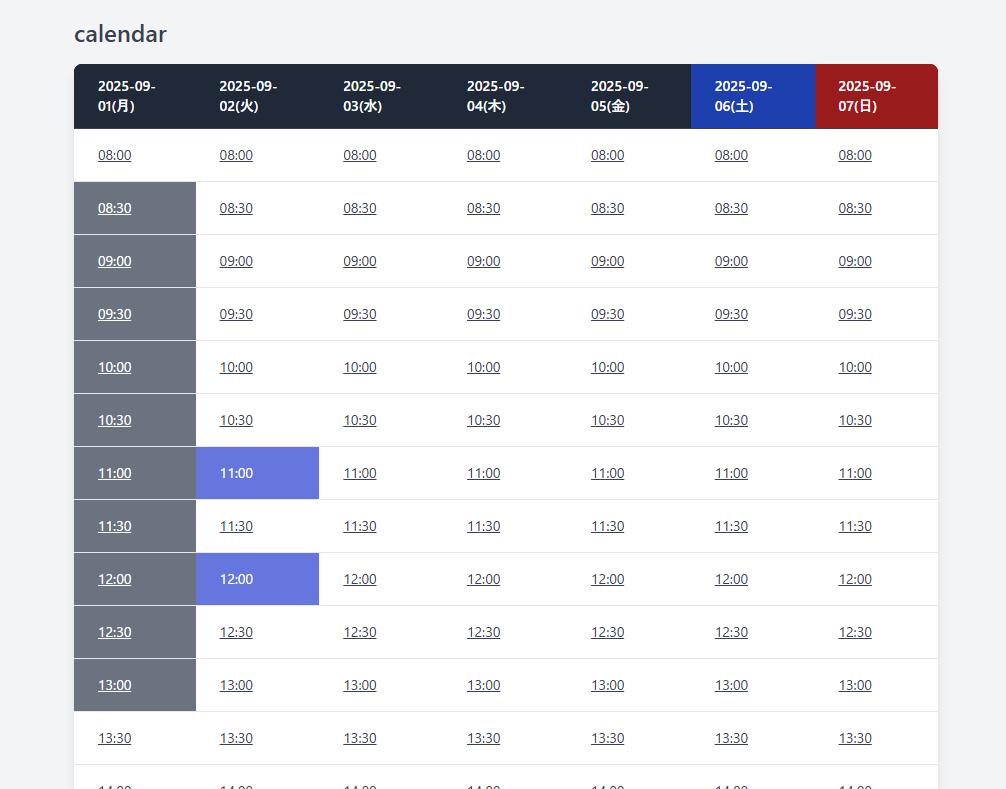

予約システム(仮)を作った話をRECしてとか

2025.09.14

おはようございます.予約システム(仮)を作った話をYOUTUBE用にRECしてとかコードを昨日のお昼まで大体作ってました.結局、エンジニアさんが欲している部分は事足りると思っています. あとはエンジニアさんがカスタマイズ […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

あと, エンジニア, お昼, カスタマイズ, カモ, ギットハブ, クラウドワークス, クローン, コード, こちら, これ, サン, システム, スカウト, それぞれ, ダウンロード, デモ, とき, ブログ, ページ, 予約, 仕事, 仕様, 会社, 使用, 依頼, 保存, 個人, 全部, 削減, 副業, 友人, 可能, 向け, 場合, 売り物, 大体, 工数, 明日, 昨日, 知人, 結局, 自分, 部分,

AIで記事を学習して新たな記事を生み出すにはお金が必要だと思っていたがそうでも.

2025.06.22

おはようございます.AIで記事を学習して新たな記事を生み出すにはお金が必要だと思っていたがそうでもなくローカルPCでそこら辺に落ちているLlamaモデルを持ってきてチューニングすれば何とかなるじゃねぇという思いに至った. […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

```, ;;), )。, アウト, アシスタント, アダプター, あたり, アップ, あなた, いくつ, ウォーム, エポック, エラー, エントリ, オープン, オプティマイザ, お金, クラウドサービス, グループ, クン, ゲーミング, コード, コア, ここ, こと, コミュニティ, コメント, これ, サイズ, サンプリング, サンプル, シーケンス, スクリプト, スケーリング, スケジューラー, スタイル, ステップ, スペック, すべて, ソース, そこら, タイプ, ダウンロード, タスク, ため, チューニング, ツール, データ, データセット, テーマ, ディレクトリ, テキスト, デバイス, デフォルト, トー, トークナイザー, とき, どれ, トレーナー, ドロップ, バイアス, パス, バッチ, パディング, パラメータ, バランス, ファイル, ファイルサイズ, ファインチューニング, ファインチューニングコード, フリーズ, プロ, プロンプト, マシン, マッピング, メモリ, モード, モデル, もの, ユーザー, よう, ライター, ライブラリ, ラベル, ランク, リモート, レベル, レポート, ローカル, ロード, ログ, 一般, 一部, 上記, 不要, 世界, 世界中, 並み, 並列, 予算, 付与, 以下, 以降, 企業, 使い, 使用, 係数, 保存, 個人, 優秀, 入力, 公開, 共有, 具体, 処理, 出力, 分割, 分散, 分野, 初期, 利点, 利用, 制御, 削減, 削除, 創造, 加速, 助け, 効率, 動作, 勾配, 十分, 参考, 反映, 可能, 向上, 味方, 因果, 場合, 多様, 夢物語, 大幅, 大量, 失敗, 学習, 完了, 完全, 完璧, 実現, 実行, 実質, 寄与, 対応, 専門, 導入, 少量, 工夫, 希望, 常識, 強力, 形式, 必要, 思い, 性能, 手元, 手法, 技術, 抜群, 指定, 指示, 挿入, 推奨, 推論, 提供, 整形, 新た, 方法, 日々, 明日, 明確, 明示, 時代, 時間, 最大, 最新, 最適, 有効, 未知数, 本格, 格段, 格納, 構築, 様々, 比率, 民主, 活用, 活発, 消費, 混合, 済み, 温度, 準備, 無効, 無料, 特定, 特権, 現実, 理由, 環境, 生成, 発生, 登場, 的確, 相性, 短時間, 確認, 秘訣, 移動, 程度, 管理, 節約, 精度, 終了, 結合, 結果, 続行, 能力, 自体, 自分, 自動的, 蓄積, 表現, 言語, 計算, 記事, 設定, 許可, 調整, 費用, 軽量, 追加, 通常, 適用, 選択, 重み, 重要, 量子, 開始, 開発, 関数, 閾値, 非常, 高速, 高額, 魅力,

日本語形態素解析ライブラリをVibratoに切り替えました.自動タブ生成プラグインの話.

2025.06.10

おはようございます.日本語形態素解析ライブラリをVibratoに切り替えました.今までYahoo!APIを使用して日本語形態素解析を行って自動でタブ生成を行っていましたが、脱APIの一環としてVPSサーバにデータを送信し […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

アパッチサービス, エラー, こと, サーバ, サーバー, サービス, サイト, さくら, タブ, データ, もの, ユーザー, よう, ライブラリ, レンタル, 一環, 不明, 使用, 保存, 処理, 出力, 動作, 原因, 参考, 同時, 唯一, 変更, 多発, 形態素, 感じ, 接続, 文句, 文章, 方法, 日本語, 明日, 最後, 無二, 生成, 画面, 管理, 自動, 苦労, 解析, 起動, 送信, 通信, 限り, 頻繁,

404画像をそのまま残しておくとSEOに影響があるのでどうするか?#php

2025.04.23

おはようございます.404画像をそのまま残しておくとSEOに影響があるのでどうするか?php の場合、下記のコードで404ページに飛んでいるかどうかの確認は出来る.でも毎回、確認しているとページを表示している時に遅延が発 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

```, エラー, コード, ステータス, データ, テーブル, フロントエンド側, ベストプラクティス, レンタルサーバー, 下記, 保存, 影響, 方法, 案, 毎回, 画像, 画像有無, 確認, 良い処理, 遅延,

ChatGPTで記事を生成するWordPressの無料非公式プラグイン

2024.10.09

おはようございます.ChatGPTで記事を生成するWordPressの無料非公式プラグインを作りました.動作環境はPHP8.1以上です.ご使用する場合、WordPressのプラグインフォルダに解答したフォルダを転送してご […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

APIKEY, ChatGPT, chatgpt-auto-article.zip, Open API, plugin, url, WordPress, キー, キーワード, タイトル, フォルダ, プラグイン, プラグインフォルダ, プラグイン管理画面, 保存, 最後, 無料非公式プラグイン, 生成, 生成AI, 生成記事,

JavaScriptでWebstorage使ってますか?🤔 #webstorage #javascript #cookie

2022.12.04

おはようございます。二日酔いです、遅めの更新🍃。 今日は今までフロントエンド側で使用していたcookieの処理コードをwebstorageに置き換えた理由と使い方のコードを記載します、JSでCookieを取り出すコードを […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

COOKIE, javascript, JS, webstorage, エンド, コード, データ, バニラ, ブラウザ, フロント, もの, ライブラリ, ローカル, 二日酔い, 今日, 使い方, 使用, 保存, 保管, 元, 処理, 前者, 場合, 容量, 情報, 採用, 改修, 更新, 殆ど, 無駄, 理由, 自分, 記載,

md5でいいのかそれで?。 #wp #phpcode

2022.11.17

おはようございます、いきなり寒くなりましたね。朝起きるのに勢いが必要になってきました😆。 今日はワードプレスでもパスワードの暗号化に使用されているmd5に関して思うことがあります。そもそもmd5は強固な暗号なのか?、答え […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

32, 5, echo, hash, md, no, password, php, PHPCODE, quot, rasmusl, wp, こと, そちら, パスワード, プレス, メール, ワード, 一度, 今日, 何, 使用, 保存, 元, 勢い, 場合, 得策, 微妙, 必要, 文字, 文字列, 方, 方法, 時間, 暗号, 暗号化, 朝, 答え, 総当たり, 返却, 関数,

WP予約投稿ツイートプラグイン作り方。#php言語 #code #v2

2022.10.11

おはようございます😤 お仕事に飢えてます…寒い季節ですね…。 さて、今日はWP予約投稿ツイートプラグイン作り方を記載していきます。ワードプレスでプラグインを作る場合はWordPressの下記の場所に任意のフォルダを作り、 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

2, cd, Code, description, lt, mkdir, My, mytweets, name, php, plugin, plugins, Tweets, Vers, vI, WordPress, wp, wp-content, アップロード, お仕事, コメント, サーバー, それぞれ, ツイート, ディレクトリ, バージョン, ファイル, フォルダ, プラグイン, プレス, ワード, 上部, 下記, 中, 予約, 今, 今日, 任意, 作り方, 保存, 名残, 命名, 場合, 場所, 変更, 季節, 後, 投稿, 昔, 言語, 記載, 説明,

1万件のCSVを読み込みテーブルに保存する雛形コード #PHPCode

2022.09.08

おはようございます、徐々に秋ぽっい日差しになってきましたね(まだ暑いけども😌)。 今日は、1万件のCSVを読み込みテーブルに保存する雛形コードを昨日、ちょちょっと書きましたので記載します。ファイルをダウンロードして使いた […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

0, 1, 7, 8, CSV, fgetcsv, github, null, php, PHPCODE, qiita, SQL, アクセス, エラー, コード, こちら, コマンド, これ, ご使用, ご自身, ダウンロード, ちょ, テーブル, ファイル, ブログ, リンク, 一, 一部, 万, 下, 今日, 保存, 動作, 参考, 変更, 実行, 方, 方法, 日差し, 昨日, 有言実行, 注目, 環境, 秋, 簡単, 記載, 雛形,

世界2.0、お金2.0の著者、かなりキレキレだなって思いますよ。

2022.05.19

おはようございます。今のところ6月の予定が全然ありません…。 世界2.0、お金2.0の著者、佐藤航陽さんはかなりキレキレだなって思いますよ。もともと弁護士?裁判官?を目指していた人みたいだけど、大学の時に試験の制度が変わ […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

2.0, 6, IT, youtube, お金, かなり, キレキレ, こと, これ, すきま, スマホ, ところ, 世界, 予定, 人, 今, 仮想, 企業, 佐藤, 保存, 内容, 制度, 勉強, 動画, 大学, 実際, 対談, 弁護士, 方向, 時, 時間, 本, 無料, 空間, 経営, 経営者, 自分, 航, 著者, 衛星通信, 裁判官, 試験, 通勤, 通学, 陽, 電車, 頃, 頭,

ブラウザに画像をドロップして表示させる部分的な処理(javascript)。これを使って?

2021.10.07

本日はブログを更新するのがいつもよりかなり遅めです?、2000記事を超えてからネタが尽きているようにも思いますが、何とか毎日更新出来ています。ネタが尽きたら少し充電しようかなと思います。 さて、ブラウザに画像をドロップし […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

2000, createElement, document, inp, input, javascript, obj, quot, var, アクセス, かなり, コード, こちら, こと, これ, これら, サーバー, サービス, ソース, デバッグ, ドロップ, ネタ, ブラウザ, ブログ, 保存, 充電, 全体, 処理, 完成, 少し, 更新, 本日, 機能, 毎日, 画像, 紹介, 表示, 記事,

FF14を自動起動させてパスワード入力を

2021.03.23

Power Automate Desktop使用してFF14を自動起動させてパスワード入力する事を試みる。パスワード入力の動作を録画して再現して実行してみると動かないので自分で直しました。当初はUI Pathを活用して試 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

14, Automate, Desktop, FF, path, PC, Power, UI, アプリ, ウェイト, キー, こと, これ, ご自身, テキスト, パス, パスワ, パスワード, フリー, プレイ, フロー, ワン, 上記, 下記, 事, 他, 使用, 保存, 入力, 再現, 再生, 動作, 単純, 実行, 当初, 待ち時間, 後, 必要, 方, 方法, 最中, 活用, 自分, 自動, 設定, 調整, 起動, 送信, 部分, 録画,

マウスの動きをトラッキング(追跡)する。

2020.11.17

サイトのマウスの動きをトラッキングして行動パターンを知りたいという案件がクラウドでありました。応募はしていませんが考え方はこのような感じだと思います。ただ楽天サイトだという制約があったのでクロスサイトへ接続可能なのかはわ […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

demo, IP, JS, php, あるかな, キャプチャ, クライアント, クラウド, クロス, コード, サイズ, サイト, ソース, それ, データ, トラッキング, パターン, ブラウザ, ページ, マウス, ライブラリ, リンク, 事, 使用, 保存, 側, 内容, 再度, 処理, 制約, 可能, 場合, 完結, 実際, 必要, 応募, 感じ, 接続, 案件, 楽天, 機能, 状態, 画面, 考え方, 行動, 返却, 追加, 追跡, 送信,

PowerShellであれ使えるだな。

2020.10.15

あれというのはwgetというダウンロードするときなどに使用するcommandです。リナックス系を使用している人には使っている方も多いかもしれない。そんな素敵なcommandがウィンドウズ10のPowerShell7では使 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

-Command, -OutFile, 10, 7, IT, powershell, Python, quot, url, VB, VBA, wget, あれ, ウィンドウズ, おすすめ, クリック, それ, ダウンロード, たま, とき, パス, パソコン, ひと, ファイル, リスト, リナックス, 事務, 人, 仕事, 作業, 使用, 保存, 全員, 効率, 勉強, 変換, 大量, 必要, 方, 物, 環境, 画像, 素敵, 結果, 自分,

手前味噌な機械学習!?。

2020.09.01

分類分けで機械学習教師ありのモデルを作り、新たなデータで推測するという一連の過程をやってみたよーーー?ちなみに分類分けとしてはあまり機能していないだけどね・・・。何が難しかったか・・・Pythonをサーバで動かすようにす […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

1, Python, あと, いろいろ, コード, これだけ, サーバ, サンプル, それぞれ, データ, ところ, ファイル, モデル, やつ, 一連, 今回, 今後, 他, 何, 保存, 全て, 処理, 分け, 分類, 学習, 完成, 感覚, 手前味噌, 手直, 推測, 教師, 機械, 機能, 生成, 表示, 解説, 質問, 途中, 連携, 過程, 部分, 重み, 面倒,

All in One SEO一括、自動入力したった。

2020.07.16

All in One SEO一括、自動入力したった。そのままです。SEO入力欄にデータを流し込みました。前処理として記事のID番号を列挙してJSONで保存しそのIDデータを使用してSEOタイトル、SEO ディスクリプショ […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

39, all, Asia, class, construct, date, db, default, DIR, function, ID, in, json, lt, null, once, one, php, public, quot, require, SEO, set, timezone, Tokyo, wp-load, キーワード, ここ, それぞれ, タイトル, タグ, データ, ディスクリプション, プログラム, もの, 一括, 使用, 保存, 入力, 入力欄, 内容, 処理, 列挙, 前処理, 想像, 数, 方向, 番号, 結果, 自動, 記事, 記載,

一時間に一回だけAPIを実行するPHPのオブジェクトファイル

2020.01.10

あるユーザーが公開しているプログラミングを参考にしてオブジェクト化してみた。参考にしたサイトのリンクは下記になります。phpでapiを切りの良い時刻までキャッシュする 尚、動作環境はPHP5.6以上になります、と言いつつ […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

5.6, API, class, cron, hour, json, lt, php, public, timeKeeper, エラー, オブジェクト, キャッシュ, コード, こちら, サーバ, サイト, ソース, ダウンロード, ため, テスト, ファイル, プログラミング, ユーザー, リンク, 一, 上書き, 下記, 保存, 公開, 内容, 処理, 動作, 参考, 場合, 実行, 差異, 時刻, 時間, 更新, 案, 環境, 結果, 自分, 設定,

WordPressのメディアライブラリについて愚痴る。

2020.01.08

過去のデータベースを引き継いでいればメディアライブラリのデータは壊れないが、途中でXMLなどデータをインポートするとメディアライブラリでは管理出来なくなってしまう。 これを呼び戻すには Add From Server や […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

Add, from, FTP, media', postmeta, posts, SERVER, url, WordPress, wp, xml, アップロード, インポート, これ, つもり, データ, データベース, トラブル, プラグイン, メディア, ライブラリ, 一括, 下記, 事, 今回, 使用, 保存, 問題, 場合, 新規, 昔, 構築, 物, 画像, 管理, 編集, 自作, 自分, 記録, 途中, 過去, 際,

内容まで¥r¥nで書かれたCSVコードを整形する簡単な方法。

2019.10.19

内容まで¥r¥nで書かれたCSVコードを整形する簡単な方法。 CSVの内容まで¥r¥nで書かれているとプログラム(PHP)で読み込みが とても面倒くさいなので、自分は手っ取り早い方法で整形を行いました。 まずCSV編集専 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が30代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

CSV, explode, php, エディター, ギガ, コード, こと, ソフト, ファイル, プログラム, ユニーク, 但し, 何か, 使用, 保存, 値, 全て, 内容, 再度, 分離, 列, 単位, 可能, 場合, 容量, 専用, 整形, 文字, 方法, 最後, 簡単, 終端, 編集, 自分, 行端, 記入, 追加, 通用,

Tera Termで自動ログインする方法:秘密鍵有り無し対応

2019.09.14

秘密鍵有り自動ログイン connect ‘ホスト名:22 /ssh /2 /auth=publickey /user=ユーザー名 /passwd=パスワード /keyfile=秘密鍵’ wait ‘#’ sendln ‘ […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が30代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

2, 22, auth, cd, connect, html, keyfile, ls, nbsp, passwd, password, publickey, sendln, SSH, Tera, Term, TTL, user, var, wait, くだ, コピペ, それぞれ, テキスト, パスワード, ファイル, ホスト, ユーザー, ログイン, 上記, 任意, 保存, 内容, 割愛, 名前, 場所, 変更, 対応, 拡張子, 方法, 有り無し, 秘密, 自動, 鍵,

画像をタイル状に分離して一括ダウンロードさせるジェネレーター

2019.09.07

画像をタイル状に分離して一括ダウンロードさせるジェネレーターを作ってみました。画像は自動的に削除されます?あることをすれば他人の画像がアップした画像も削除されます。ちなみに一括ダウンロードbuttonを押すと画像がサーバ […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が30代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

1, 14, 30, 358, 4, 5, 64, archives, base, button, Chrome, com, demo, ex, html, https, index, m-yabe, tool, www, zip, アップ, オンリー, コード, こちら, こと, サーバー, サイト, ジェネレーター, ソース, タイル, ダウンロード, はい, ファイル, ブラウザ, ページ, 一括, 下記, 他人, 保存, 処理, 分離, 削除, 動作, 参考, 問い合わせ, 変更, 強制, 格納, 生成, 画像, 表示, 複数, 追記, 選択,