GeminiCliを使ってみました、まぁまぁ使えるかもしれない.

おはようございます.GeminiCliを使ってみました、まぁまぁ使えるかもしれないというのが第一印象です、ただデザイン修正には使えそうにない.デザインを提示すればその通りになおしてくれると思うのだけどテキストだけの指示で […]

おはようございます.GeminiCliを使ってみました、まぁまぁ使えるかもしれないというのが第一印象です、ただデザイン修正には使えそうにない.デザインを提示すればその通りになおしてくれると思うのだけどテキストだけの指示で […]

おはようございます.よさこい祭り動画検索サイトに今ごろ本腰とテコ入れを行うことにして先日しごと終わってから対応を行っていました.自分には三本の柱があってその中の一本によさこい祭り動画検索サイトが存在します. ただ、三本の […]

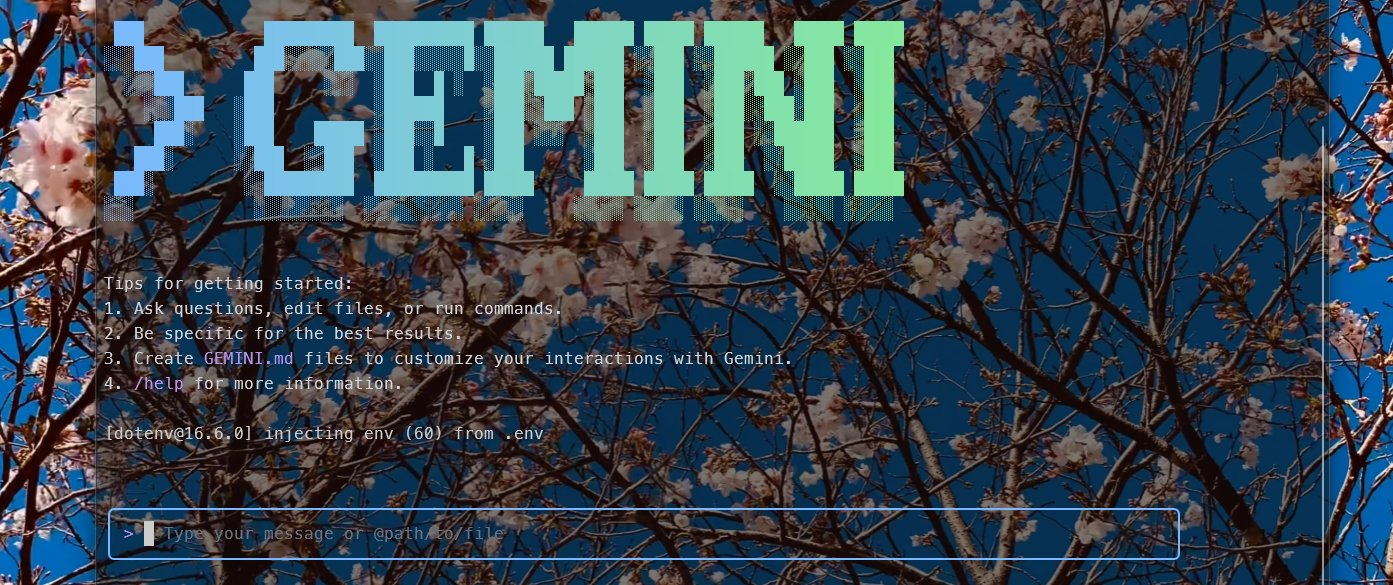

おはようございます.映画、F1/エフワンを観てきました.オチは言わないけどわかると思うブラビが出ている映画ってそうなるよね的な結末だった.ブラビファンには圧倒的に嬉しいストーリーになっていると思います. ただ、映画をいっ […]

おはようございます.昨日はデススト2の発売日でした、まだ購入はしていません. さて自分には目が覚めてから大体1時間ぐらいPCを付けてぼーっとしている時間がある、だいぶ前からだけど目が覚めてはいるけど、脳が回転していない時 […]

おはようございます.それ、勝手な決めつけかもよ?だれかの正解にしばれない「解釈」の練習をパラめくして、なるほどこの人と言わんとしている所に共感しました. 結構、名前や言葉で最初から先入観を持っている気がしていて、言葉(ニ […]

おはようございます.そう言えば昨日マイナンバーカードをiphoneに追加しました、追加方法などはこちらの記事には記載しませんがその代わりとして公式YOUTUBEの手順方法を貼っときますね. ちょっと登録が面倒ですけど一度 […]

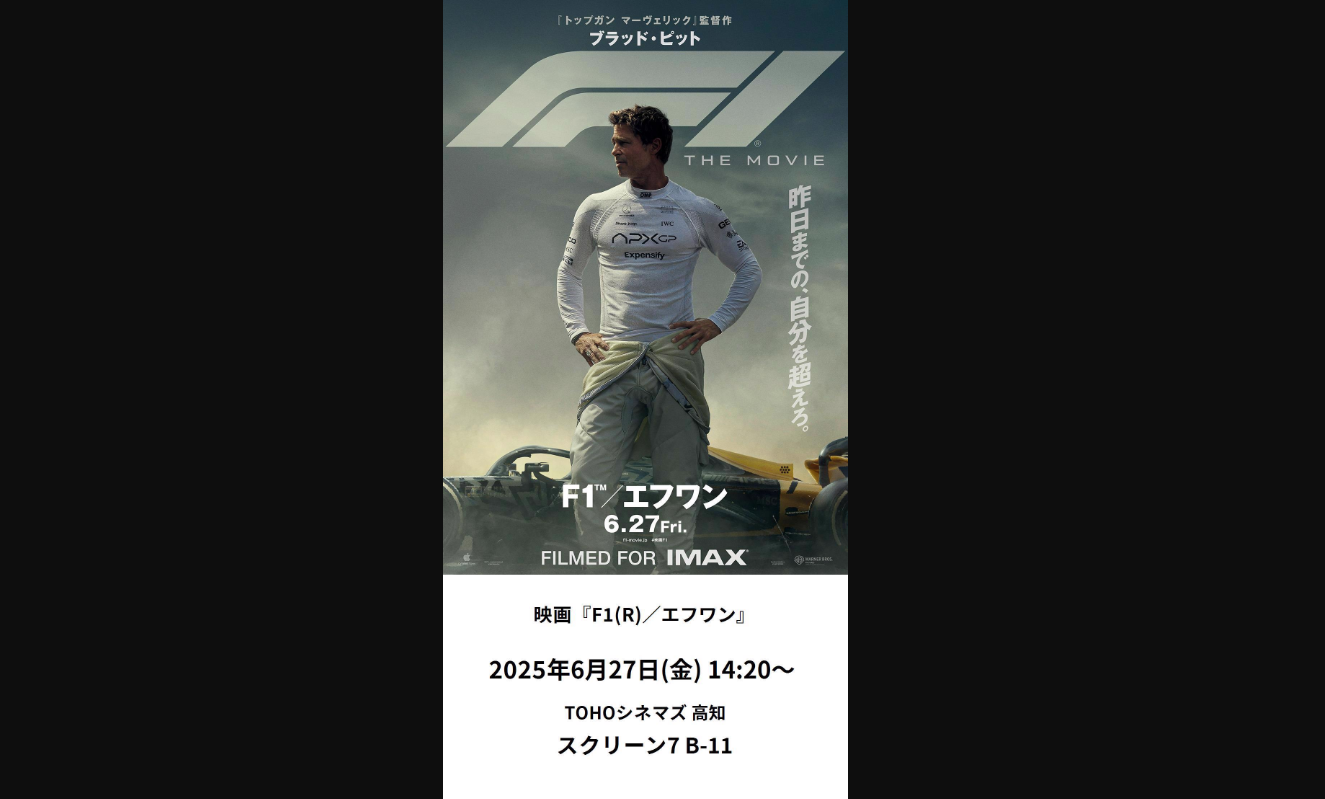

おはようございます.よく行く本屋さんに金高堂の山田店や朝倉店などがあるのだけども金高堂店のHPがシンプル過ぎてちょっと困っています.お店の地図や電話番号があるのは有り難いのだけども.決済方法が記載されていないのは、ちょっ […]

おはようございます.負の連鎖ってあるだと思う.小さいことから大きな事まである世の中だけどもこれを断ち切るには仏教が良いじゃないかなって思っている.日本が戦後、復讐をしなかったのも仏教や宗教の根本的な考えが西洋文化とは違う […]

おはようございます.AIで記事を学習して新たな記事を生み出すにはお金が必要だと思っていたがそうでもなくローカルPCでそこら辺に落ちているLlamaモデルを持ってきてチューニングすれば何とかなるじゃねぇという思いに至った. […]

おはようございます.「お金の本 図解だからわかる」と「貧乏人はお金持ち」を電子書籍で読んでみて率直にひろゆき氏が書いた「お金の本 図解だからわかる」が読みやすい、逆に貧乏人はお金持ちは読みづらい、何故か過去の歴史のウンチ […]

おはようございます.思ったことを綴って小銭が毎日入るのは良いけど毎日小銭止まりです.小銭がどれぐらいかといえばお賽銭にいれる小銭が毎日入ってくると思ってください.それが毎日入ってきて?札になる感じですが収入が銀行に毎月振 […]

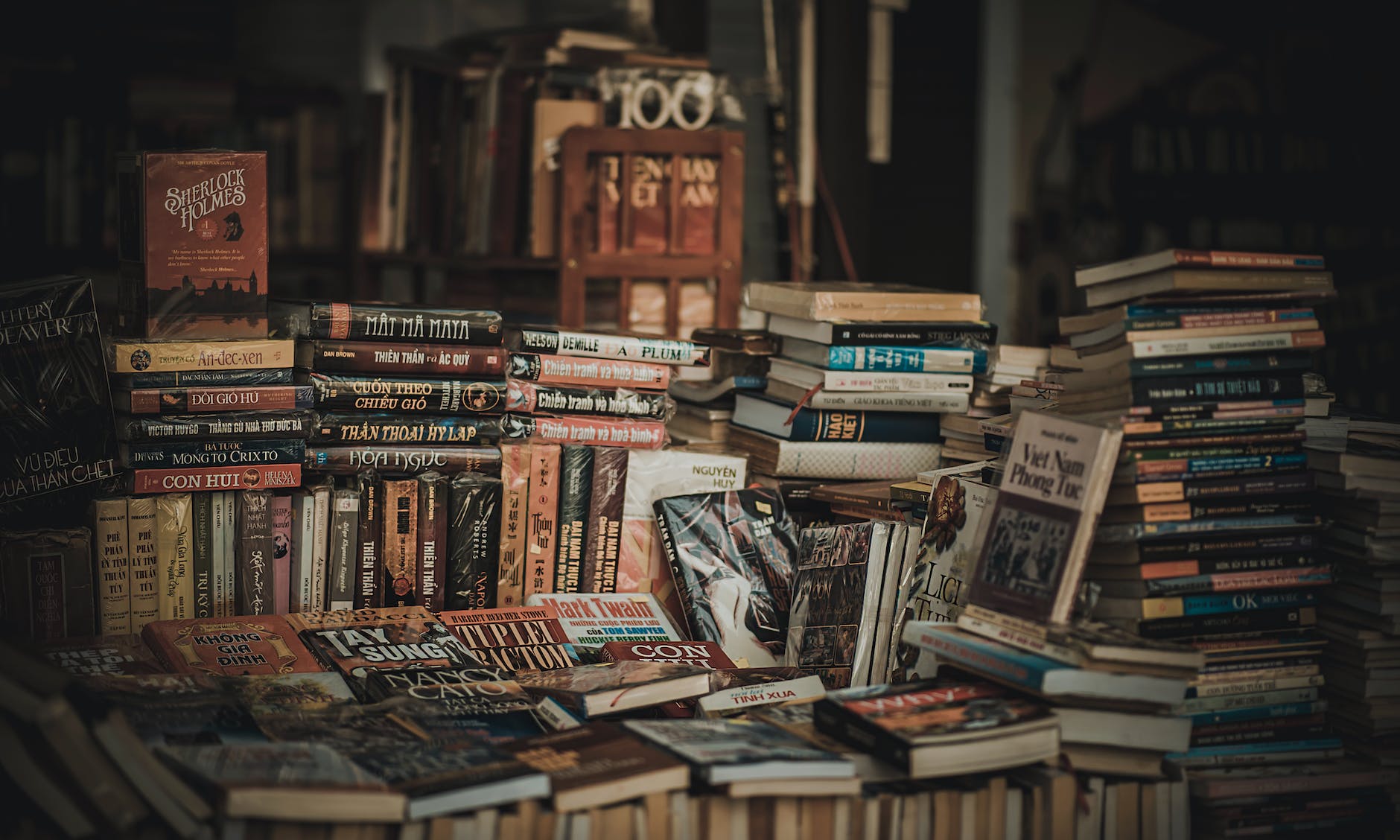

おはようございます.読書は、知識を深め、視野を広げ、心を豊かにしてくれる素晴らしい習慣です。たった15分でも、毎日続けることで多くのメリットがあります。 なぜ15分なのか? 15分という時間は、忙しい日々の中でも比較的確 […]

おはようございます.適当なアプリをリリースしました、まだ審査中だけども通過するだろう「きっと」.広告もない、個人情報の登録もないから申請するだけで通過すると思います. 因みにどんなアプリかといえば数字の桁数を漢字読みに変 […]

おはようございます.右から左に情報が抜けていく中の人が最近見て良かったなって思えた動画はこちら『【鏡の世界では物理法則がわずかに変化する】ハーバード大学物理博士課程・久保田しおん/私たちが消えずに存在している理由を探る/ […]

おはようございます.ビデオポッドキャストをたまにYOUTUBEとSpotifyで見ています、今日はその話を書いていきます.以前はポッドキャストを聴いていたのだけどビデオポッドキャストが面白いと感じることが多いです.声だけ […]

おはようございます.下記のゲーム動画を見て昔のゲームと比べると進化が著しい変化なのでついていけてないですね.でも本当に凄いと思っています. こういうゲームというのは、どうやって作るのだろうかという事が興味深いです、一応、 […]

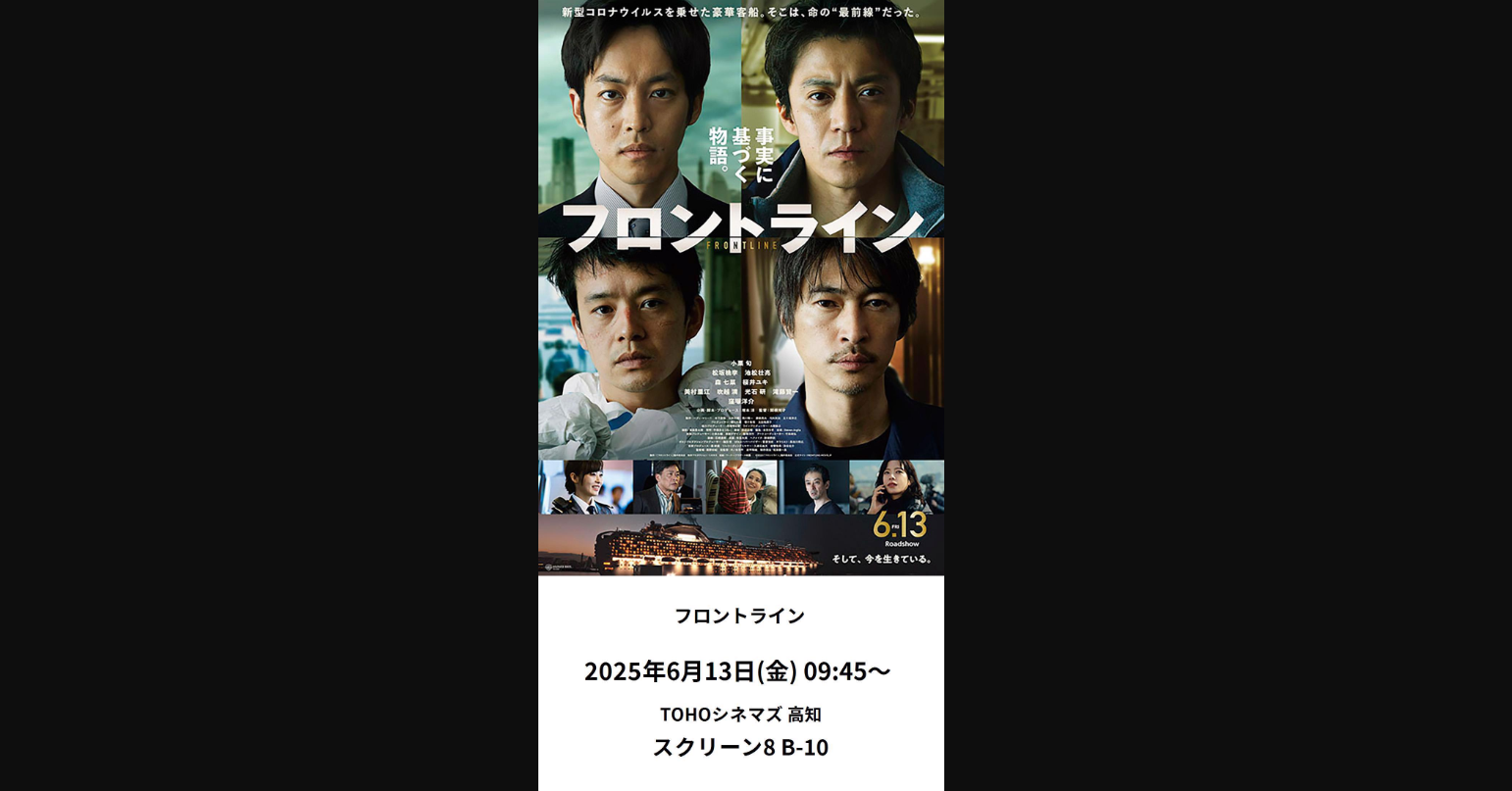

おはようございます、映画、フロントラインを観てきました、ネタバレ無しの感想を書いていきます.これは胸熱な物語でした観てよかったです、観たいなって思っている方は是非劇場に足を運んでください熱い思いがお釣りとして返ってきます […]

おはようございます.laravel sailで構築されたDockerコンテナのターミナルに入り新たなパッケージをインストールする方法は次の通りです. ①ターミナル上でbashと入力しエンターを行いルート権限にする. ②O […]

おはようございます.強制的にアプリ開発します.8月半ばまでに作らないとアカウントが停止されるので解除条件として定義されている、既存のアプリをアップデートさせるか、新たなアプリをリリースするか. 既存のアプリは非公開にして […]

おはようございます.カゴヤ・ジャパンさんのVPSのスナップショット有料何だね.無料だと思ってスナップショットをONにしていたらサーバー代が倍になってた.そう言えば何だか警告が出ていた気もする🤔. 「そうでもないか・・・警 […]

おはようございます.日本語形態素解析ライブラリをVibratoに切り替えました.今までYahoo!APIを使用して日本語形態素解析を行って自動でタブ生成を行っていましたが、脱APIの一環としてVPSサーバにデータを送信し […]

おはようございます.iphoneとAndroidがフィフティ・フィフティになりつつある日本.自分のサイトの訪問者も五分五分感があります、昔に比べてAndroidの性能が飛躍的に上がったって言う感覚はあるでコスパの良いAn […]

おはようございます.x.gdのURL短縮機能を利用するためのコードを作りましたので、お裾分けです、コードは下記になります.ドキュメントをぱぱっと見て作った感じなので不具合などが潜んでいるかもしれないけど恐らく大丈夫そうと […]

おはようございます.昨日の映画、国宝を観てきましたので感想を書いていきます.まずこの映画、国宝になるまでの話を丁寧に描いている映画です、3時間と長丁場な映画ですが納得がいく映画だと思います.この映画を観て国宝という人のイ […]