story of my life

過去の蓄積を見るために書く日記.

WPの記事を検索し一括カテゴリ変更する方法。

2020.05.25

WPの記事を検索し一括カテゴリ変更する方法は下記になります。ワードプレスのwp-load.phpを読み込み、下記のようなソースコードのファイルをcommandで実行すると、カテゴリが任意のカテゴリに変更されます。 重要点 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

-Command, 39, array, categories, CSV, DIR, ID, lt, once, php, POST, require, set, url, wp, wp-load, アウト, お願い, カテゴリ, コード, こと, コメント, ご使用, ソース, それぞれ, ナンバー, ファイル, プレス, メソッド, ワード, 一度, 一括, 下記, 不具合, 任意, 企業, 何, 何か, 使用, 場合, 変更, 実行, 引数, 当然, 後, 意味, 抽出, 数値, 方, 方法, 更新, 検索, 確認, 自己, 苦情, 記事, 責任, 部分, 配列, 重要点,

YOUTUBE、エアトレインを見た!?

2020.05.14

エアトレイン(口(声)で電車の音真似)をする人がTVで放送されていて、そのひとYOUTUBEとかで流していないかと検索すると有りました。日吉住民のVocal performance channelというチャンネルで動画を […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

1, channel-, performance, TV, UP, Vocal, youtube, ういる, エア, オト, そのひと, チャンネル, テツ, トレイン, ニッチ, ピアノ, ひと, ポジション, もの, ヲタ, 不思議, 世界, 人, 人け, 住民, 優勝, 動画, 口, 声, 大会, 山手線, 彼, 情景, 持ち主, 放送, 日吉, 最後, 東京, 検索, 登録, 系統, 経歴, 自分, 評価, 認知, 都市部, 鉄, 電車, 需要, 音,

ちょっとしたツール。

2020.05.11

サイト内の検索をするためのURLを生成してくれるツールを作りました。ドメインを入力するとあらかじめ登録しているURLの候補が表示されます。なお、プログラムでドキュメント検索する場合などに最適かなと思います、URLもプログ […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

358, com, https, search, site, tool, url, zip, お裾分け, これ, サイト, ため, ツール, ドキュメント, ドメイン, プログラム, リンク, 使用, 候補, 入力, 判断, 問い合わせ, 場合, 最後, 最適, 検索, 機能, 生成, 登録, 経緯, 自分, 表示, 追加, 関係,

Gさんのリアルタイム検索トレンドを抽出するPHPライブラリ

2020.04.15

Composerをインストールしていること前提条件として書いていきます。まずはライブラリーを入れます。 こんな感じに そして次にこんな感じのPHPコードを書きます、これだけでGさん(グーグルさん)のリアルタイム検索トレン […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

autoload, com, Composer, g-trends, github, GTrends, https, include, json, lt, once, options, php, quot, require, use, vendor, x-fran, XFran, あと, インストール, グーグル, コード, こと, これだけ, トレンド, メソッド, ライブラリ, ライブラリー, リアルタイム, 下記, 処理, 前提, 参照, 可能, 感じ, 抽出, 条件, 検索, 簡単, 表示,

NPO法人検索サービスを作りましたよ。

2020.04.05

全国各地のNPO法人を検索できるサービスです。閉鎖されているサービスも検索にヒットするのがたまに傷ですが・・・。非表示にすることも可能ですがあえて表示させています。 NPO法人を使用されたい方、NPOで活動されたい方は是 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

NPO, url, こと, サービス, たま, ヒット, 下記, 使用, 傷, 全国, 可能, 各地, 御活用, 方, 検索, 法人, 活動, 表示, 閉鎖,

土佐電時刻表検索サービス復刻版を作りました?

2020.03.06

土佐電時刻表検索サービス復刻版を作りました。公表もせずにローカルでしか試していなかったものですが、この度、時刻表をクロールしてサイトからデータを抽出して、そのデータを元に土佐電時刻表の検索サービスを作りました。 パチパチ […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

BOT, SEO, url, アクセス, クロール, こちら, ご連絡, サービス, サイト, ダイレクト, ツイート, データ, ヒット, ホヤホヤ, もの, ローカル, わけ, 不具合, 人, 今日, 元, 公表, 収益, 土佐, 対策, 度, 復刻, 所, 抽出, 昔, 昨日, 時刻表, 本日, 検索, 稼働, 限り, 電, 高知県,

検索サイトが無かったら、仕事ができないプログラマー。

2020.02.21

検索サイトが無かったら、仕事ができないプログラマーはいっぱいる。たぶん90%ぐらい締めているじゃないかな?どこかのライブラリを使用したい場合とかもだいたい検索サイト使っているし、何かフリーツールが欲しくても検索サイトが無 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

1, 2, 90, IQ, IT, SNS, いっぱい, お世話, お仕事, サイクル, サイト, その他, それぐらい, ダウン, ツール, とき, どこか, フリー, プログラマー, ライブラリ, 一方, 中々, 事, 人, 今, 仕事, 企業, 使用, 場合, 少し, 情報, 技術, 持ち主, 日進月歩, 検索, 業界, 次, 知識, 自分,

システムエンジニアの1日を撮ったvlog(one day)

2020.01.30

システムエンジニアの1日を撮ったvlogが海外では流行っていたのか、結構検索するとヒットする、大手のIT企業で働いている人もvlogを撮っているので興味のある方は視聴してみてはどうだろうかと。日本の場合、IT企業が宣伝目 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

-brF, 1, 6, com, day, IT, one, SUXbns, Vlog, youtube, エンジニア, かなり, コード, こと, これ, システム, そこ, そこら, ヒット, ブラック, フリー, プログラマー, ランス, 事, 人, 企業, 個人, 内容, 動画, 可能性, 場合, 大手, 宣伝, 差, 彼ら, 方, 日本, 検索, 海外, 理想, 環境, 目的, 自分, 自身, 興味, 視聴, 責任, 通り, 雲泥,

パンくずリストの構造化を変えない人がいるよ。

2020.01.29

Gさんから、data-vocabulary.org schema deprecated のお叱り(警告)が出た方はschema.orgの形式の構造体に変更しなくてはなりません。パンくずリストって何って方はまずググってみて […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

BreadcrumbList, data-vocabulary, deprecated, gt, http, itemscope, itemtype, li, lt, ol, org, quot, schema, お叱り, かなり, クス, クリック, コード, こと, これ, サイト, タグ, パン, もの, リスト, 事, 人, 以前, 会社, 何, 効果, 変更, 対応, 差, 形式, 感じ, 方, 時, 検索, 構造, 構造体, 表示, 誰, 警告, 雲泥,

WEB担当者様各位、サジェスト機能(予測変換)を意識している?

2020.01.24

サジェスト機能(予測変換)を意識しているブロガーやアファリエターの方は結構多いと思いますが、自分はそれを全然意識はしていませんし、調査して文章を書いていません。本当は意識した方が良いだろうけれど、例えば人工知能でサジェス […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

web, アファ, おすすめ, キーワード, こと, これ, サーチ, サジェスト, それ, たー, ブロガー, ブログ, リエ, 三, 上位, 下記, 予測, 事, 人工, 使用, 候補, 公開, 内容, 再生, 動画, 単語, 各位, 変換, 大事, 情報, 意味, 意識, 担当者, 文章, 方, 有益, 本当, 検索, 機能, 殆ど, 激戦区, 状態, 理解, 知能, 自分, 表示, 記事, 調査, 進化,

大体のYOUTUBERの稼ぎが分かるサイト?

2020.01.23

これでHikakinTVチャンネルの収益を覗いてみると月の収入が凄いことになっている。もう一生分稼いでいるよね・・・。これぐらい稼ぎ出すと働くことの考え方が変わりそうな気がします。ちなみに自分の登録者数は片手で数えること […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

1000, com, HikakinTV, jp, noxinfluencer, youtube, YOUTUBER, インフルエンサー, お金, お願い, ググル, こと, これ, これぐらい, サイト, ため, チャンネル, ノックス, ヒット, ブログ, リンク, 一生, 上記, 上限, 人, 公開, 再生, 分析, 動画, 収入, 収益, 回数, 大体, 挫折, 月, 検索, 気, 片手, 登録, 登録者, 目安, 考え方, 自分, 規定, 話, 道のり, 面倒,

漁業系ユーチューバーさん、小豆島の漁師はまゆう

2020.01.20

そりゃいるさー。本日(20/1/20)のAM11時頃、農業系ユーチューバーを紹介しました。農業系YOUTUBERがいるなら、漁業系ユーチューバーがいてもおかしくないじゃないと検索したところいましたよ! 小豆島の漁師はまゆ […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

1, 11, 20, AM, youtube, YOUTUBER, イケメン, いま, オーシャン, こと, サービス, とき, ところ, ニッチ, はまゆう, ひと, ブルー, まゆう, もの, ユーチューバー, レッド, 一人, 中々, 事, 人, 大変, 小豆島, 本日, 本業, 検索, 漁師, 漁業, 発信, 皆, 納得, 紹介, 職業, 自分, 認識, 農業, 部分,

農業系ユーチューバーさんのちょこっと自然農チェンネル

2020.01.20

農業系ユーチューバーさんのちょこっと自然農チェンネルです。いろいろなジャンルがあるなと関心します。これからもある程度、収益の出ているいろいろなYOUTUBERをピックアップしていきますね。 さて農業系ユーチューバーさんの […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

5000, 8, 9, YOUTUBER, いま, イメージ, いろいろ, うち, これ, サラリーマン, ジャンル, ゼロ, ため, チェン, とき, ところ, ネル, ピックアップ, ユーチューバー, ユーチューブ, 万, 世帯, 他, 何故, 公表, 割, 動画, 千, 収入, 収益, 問題, 大変, 安定, 実際, 検索, 登録者, 知識, 経営者, 自分, 自然, 興, 跡継ぎ, 農, 農地, 農業, 関心,

ハローワークサイトの仕様が変わった、使いづらいよ!! #ハローワーク

2020.01.06

本日(高知県)からおそらく高知県のハローワーク検索端末が変わったみたい?ウェブ(ホームページ)のハローワークサイトと統合した形になっている。要するに、わざわざハローワークへ行かなくても自宅で検索できるようになったというこ […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

common, go, hellowork, https, JS, mhlw, php, WARNING, www, アクション, ウェブ, エラー, お仕事, こと, コメント, これ, サーブ, サイト, じぶん, トイウコトデ, ところ, ナンバー, ハローワーク, ホームページ, レッド, わざわざ, 一つ, 下請け, 仕様, 何次, 便利, 問い合わせ, 形, 所, 最寄り, 本日, 検索, 端末, 素人, 統合, 自宅, 記述, 警告, 関心, 難読, 高知県,

嘘半分のWEB事情、WEBのタブーを書いてみる。

2019.11.29

嘘半分のWEB事情、WEBのタブーを書いてみる。毎日ブログを書けばブログのアクセスアップが出来ますよ。これは半分本当で半分ウソである、いくら短文の投稿を有名人のように毎日書いたとしてもアクセス数はほとんどアップしない。 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が30代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

htaccess, web, アク, アクセス, アップ, いま, ウソ, きっかけ, これ, サーバ, サイト, タブー, ドメイン, パス, ブログ, ほとんど, リダイレクト, ルート, 一, 上, 事情, 何か, 候補, 判断, 半分, 可能性, 嘘, 場合, 投稿, 方法, 有名人, 本当, 検索, 毎日, 現在, 直下, 短文, 記事, 設置, 購入, 運用, 重要, 長文,

難しいの基準(プログラム初心者へ)

2019.11.15

難しいの基準、プログラムが難しいと思っている人がいますがそんなに難しいものではないです。 つい最近、人工知能のさわりを試行錯誤しながら行ってみました。Aという文章から新たな文章を生成するというものです。機械学習の部分はあ […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が30代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

php, コード, こと, コピー, さわり, ソース, つい, ところ, ヒット, ひと, ひとは, プログラム, モデル, もの, 人, 人工, 作り方, 処理, 初心者, 動作, 参考書, 基準, 学習, 意味, 掲示, 文章, 方法, 最初, 最近, 検索, 機械, 機能, 次, 殆ど, 理解, 生成, 知能, 編集, 言語, 試行錯誤, 部分,

何でもどうぞとすごく挑戦的ですね。グーグルさんの検索入力ボックス

2019.11.10

グーグルさんの検索入力ボックス 何でもどうぞとすごく挑戦的ですね。ついに何でも検索できるようになったのか? プレースホルダー(placeholder:入力ボックスの灰色文字部分)の文字が「何でもどうぞ」になっている件、恐 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が30代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

AI, placeholder, オチ, グーグル, ため, ひと, プレース, ボックス, ホルダー, 人, 人工, 件, 入力, 学習, 後者, 意味, 意図, 挑発, 文字, 検索, 灰色, 理解, 知能, 結果, 罠, 部分,

エンジニアはクラウドなんたらで働くより稼げる方法。

2019.11.10

フリーランスのエンジニアはクラウドなんたらで働くより稼げる方法はエージェント(代理人)を通してお仕事をもらう方法が良い思います。 それなりに経験があるエンジニアさんはこの方法で働いたほうが稼げます、ちなみに関東、関西など […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が30代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

いろいろ, うち, エージェント, エンジニア, お仕事, クラウド, こと, サイト, それなり, たら, フォロー, フリー, ランス, リモート, ワーク, 仕事, 代理人, 体制, 前提, 単価, 大体, 強み, 数, 方法, 最高, 条件, 東京, 案件, 検索, 比較, 現場, 経験, 職種, 表示, 関東, 関西,

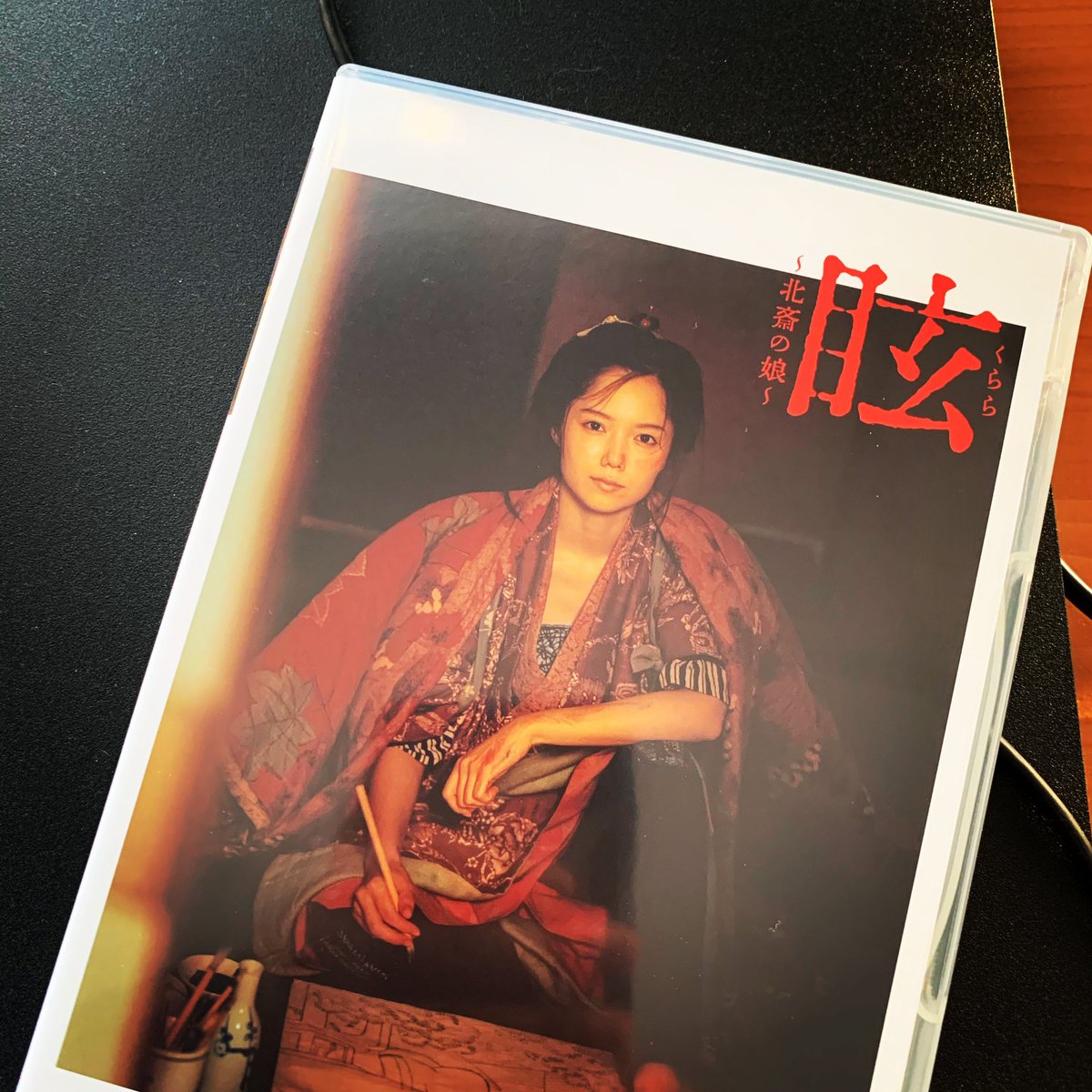

眩(くらら)?北斎の娘?が良かったー!

2019.11.09

眩(くらら)?北斎の娘?というドラマがNHKで放送されていたのですがこれ、かなり大好きな作品です。内容が良いです、ほんとに。 モノづくりをしている=クリエイターがみると共感できるところがあるじゃないかなとそんな内容が散り […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が30代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

000, 2017081436, 2021, Blu-ray, goods, https, jp, NHK, nhk-ondemand, SA, www, あおい, いま, オンデマンド, かなり, くらら, クリエイター, これ, たー, とき, ところ, ドラマ, ほんと, もの, 人, 作品, 共感, 内容, 出演, 北斎, 娘, 娘役, 宮崎, 放送, 検索, 発売, 眩, 自分, 葛飾北斎, 視聴, 購入, 追記,

自分の務めてる会社の1次入社試験(過去問)

2019.10.12

自分の務めてる会社の入社試験(過去問)です。 これぐらいのことは出来てもらわないと困るという事で出題したのですが どうもこの問題難しいのか? ここまで漕ぎ着けて採用された人はひとりしかいない。 大手の会社にはこんなの簡単 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が30代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

1, 2, 3, 358, Code, com, php, postal, search, tool, zip, ここ, こと, これ, これぐらい, これだけ, サジェスト, たくさん, どちらか, ひとり, また下, 中々, 事, 人, 今, 企業, 会社, 使用, 入力, 入社, 処理, 出題, 募集, 同期, 問題, 地方, 大手, 採用, 条件, 検索, 機能, 現状, 番号, 簡単, 結果, 自分, 表示, 言語, 記, 試験, 過去問, 郵便, 零細,

動画を無音声に変換するバッチ

2019.09.28

こらからプログラムしている所のVlogを撮ろうと 月曜日に、WEBカメラを新調しました。 いざ撮影してみると部屋の雑音などが入ってしまうので 音声カットする方法は無いのかなと フリー編集ソフトをググっていたのだけど フリ […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が30代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

Bat, ffmpeg, Vlog, web, Windows, おすそ分け, お使い, カット, カメラ, コード, こと, コピー, ソフト, だなー, テキスト, バッチ, プ, ファイル, フォルダ, フリー, プログラマー, プログラム, もの, ロゴ, 下記, 事, 動画, 名前, 場合, 変換, 変更, 存在, 後, 所, 拡張子, 撮影, 断念, 新調, 方法, 最初, 月曜日, 検索, 用, 直下, 編集, 自分, 表示, 解凍, 部屋, 開発, 雑音, 音, 音声,

SQLの無知さ加減。

2019.07.13

select id,namae,furigana from passport where id = ANY(select id from travellist where namae like “田中%”); 自分のSQ […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が30代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

ANY, from, furigana, HIT, ID, IT, like, namae, passport, select, SQL, travellist, where, キー, クエリ, こと, サブ, はり, メンター, 事, 今, 会社, 作業, 処理, 削除, 前, 加減, 半端, 存在, 対応, 対象, 更新, 最初, 検索, 構文, 無知, 田中, 自分, 複数, 解析, 追加, 際,

tensorflowは簡単にインストールできるけど、そこから何やれば

2019.02.09

tensorflowは簡単にインストールできるけど、そこから何やれば 良いのか、よくわからない。 いま流行りの人工知能ですが、こういうこと出来るよってのは 知っている、例えば画像の仕分けとか。 そこからオリジナルに適応で […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が30代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

10, 40, tensorflow, アプリ, いま, インストール, オリジナル, グーグル, グロ, こと, これ, コンソール, さすが, そこ, ダウンロード, モザイク, 人, 人工, 仕事, 他, 公開, 写真, 収集, 変更, 小耳, 工事, 役, 恥, 本屋, 検索, 気, 活用, 現場, 画像, 知能, 簡単, 若気, 若造, 適応, 間近, 顔,

google NewsをRSSで取得してjsonで返却するPHPプログラム

2018.12.22

google NewsをRSSで取得してjsonで返却するPHPプログラムです。ご自由にご使用ください。

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が30代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

0, channel-, cnt, com, defence, file, foreach, function, gl, Google, gt, headlines, hl, https, if, isset, item, ja, jp, json, load, lt, ned, News, null, obj, object, php, POST, quot, res, RSS, section, sh, simplexml, urlencode, void, xss, キーワード, プログラム, 取得, 検索, 返却,

たぶん今までのSEOが有効じゃなくなる時代へ。

2017.10.31

たぶん今までのSEOが有効じゃなくなる時代へ 突入するだろうと思っています。 何故ならAIの進化が目覚ましいから、そしてビックデータの活用も かなりに凄いところまで来ている。AIとビックデータは相性が良い、 そして、検索 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が30代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

AI, SEO, シンギュラリティ, ビックデータ, ランク, 一人ひとり, 人工知能, 人類, 何気ない挿絵, 優越, 判断基準, 時代, 有効性, 検索, 生命, 良し悪し, 近いエッセンス版, 進化,