story of my life

過去の蓄積を見るために書く日記.

AIで記事を学習して新たな記事を生み出すにはお金が必要だと思っていたがそうでも.

2025.06.22

おはようございます.AIで記事を学習して新たな記事を生み出すにはお金が必要だと思っていたがそうでもなくローカルPCでそこら辺に落ちているLlamaモデルを持ってきてチューニングすれば何とかなるじゃねぇという思いに至った. […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

```, ;;), )。, アウト, アシスタント, アダプター, あたり, アップ, あなた, いくつ, ウォーム, エポック, エラー, エントリ, オープン, オプティマイザ, お金, クラウドサービス, グループ, クン, ゲーミング, コード, コア, ここ, こと, コミュニティ, コメント, これ, サイズ, サンプリング, サンプル, シーケンス, スクリプト, スケーリング, スケジューラー, スタイル, ステップ, スペック, すべて, ソース, そこら, タイプ, ダウンロード, タスク, ため, チューニング, ツール, データ, データセット, テーマ, ディレクトリ, テキスト, デバイス, デフォルト, トー, トークナイザー, とき, どれ, トレーナー, ドロップ, バイアス, パス, バッチ, パディング, パラメータ, バランス, ファイル, ファイルサイズ, ファインチューニング, ファインチューニングコード, フリーズ, プロ, プロンプト, マシン, マッピング, メモリ, モード, モデル, もの, ユーザー, よう, ライター, ライブラリ, ラベル, ランク, リモート, レベル, レポート, ローカル, ロード, ログ, 一般, 一部, 上記, 不要, 世界, 世界中, 並み, 並列, 予算, 付与, 以下, 以降, 企業, 使い, 使用, 係数, 保存, 個人, 優秀, 入力, 公開, 共有, 具体, 処理, 出力, 分割, 分散, 分野, 初期, 利点, 利用, 制御, 削減, 削除, 創造, 加速, 助け, 効率, 動作, 勾配, 十分, 参考, 反映, 可能, 向上, 味方, 因果, 場合, 多様, 夢物語, 大幅, 大量, 失敗, 学習, 完了, 完全, 完璧, 実現, 実行, 実質, 寄与, 対応, 専門, 導入, 少量, 工夫, 希望, 常識, 強力, 形式, 必要, 思い, 性能, 手元, 手法, 技術, 抜群, 指定, 指示, 挿入, 推奨, 推論, 提供, 整形, 新た, 方法, 日々, 明日, 明確, 明示, 時代, 時間, 最大, 最新, 最適, 有効, 未知数, 本格, 格段, 格納, 構築, 様々, 比率, 民主, 活用, 活発, 消費, 混合, 済み, 温度, 準備, 無効, 無料, 特定, 特権, 現実, 理由, 環境, 生成, 発生, 登場, 的確, 相性, 短時間, 確認, 秘訣, 移動, 程度, 管理, 節約, 精度, 終了, 結合, 結果, 続行, 能力, 自体, 自分, 自動的, 蓄積, 表現, 言語, 計算, 記事, 設定, 許可, 調整, 費用, 軽量, 追加, 通常, 適用, 選択, 重み, 重要, 量子, 開始, 開発, 関数, 閾値, 非常, 高速, 高額, 魅力,

お金の本 図解だからわかると貧乏人はお金持ちをパラめくして

2025.06.21

おはようございます.「お金の本 図解だからわかる」と「貧乏人はお金持ち」を電子書籍で読んでみて率直にひろゆき氏が書いた「お金の本 図解だからわかる」が読みやすい、逆に貧乏人はお金持ちは読みづらい、何故か過去の歴史のウンチ […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

!」, アップデート, あと, アドバイス, イラスト, うんちく, おすすめ, お金, グローバル, ゴースト, コスパ, こと, サザエさん, サラリーマン, サン, システム, シンプル, ストレス, ソシャゲ, それぞれ, ターゲット, タイトル, ため, チャン, どちら, どれ, ひろ, ファイナンス, フリーエージェント, マイクロ, メンタル, もの, ゆき, よう, リボ, レベル, 一刀両断, 一家, 一貫, 不可欠, 不安, 不幸, 世界, 主張, 主義, 予備, 人生, 仕組み, 以下, 企業, 会社, 会計, 体系, 使い方, 依存, 保護, 保険, 優遇, 具体, 内容, 出版, 分野, 利用, 利益, 制度, 加筆, 動画, 博之, 合法, 啓発, 図解, 国家, 基本, 変化, 大切, 大胆, 失敗, 宝くじ, 実践, 対応, 専門, 崩壊, 工夫, 常識, 幸せ, 従来, 心掛け, 情報, 意見, 感じ, 戦略, 所得, 手取り, 技術, 投資, 指摘, 措置, 提案, 提示, 方法, 明日, 明確, 時代, 時間, 書籍, 最大, 最新, 最適, 本書, 栄養剤, 楽園, 模索, 正式, 歪み, 歴史, 法人, 法律, 活用, 無税, 無駄遣い, 特徴, 状況, 独立, 率直, 現代, 現状, 理解, 生き方, 生命, 生活, 疑問, 発想, 直感, 相手, 知識, 示唆, 社会, 社長, 税制, 税理士, 税金, 端的, 競争, 箇所, 管理, 終焉, 終身, 経済, 経験, 結婚, 考え方, 自分, 自己, 自由, 自身, 著者, 融資, 行動, 西村, 視点, 解消, 解説, 記載, 設立, 評判, 負担, 貧乏, 貧乏人, 資本, 資金, 購入, 起業, 通り, 運用, 過去, 道具, 違い, 選択, 部分, 重要, 金利, 金持ち, 関係, 雇用, 電子,

ハーバード大学物理博士課程・久保田しおんさんのトークが面白いかと.

2025.06.17

おはようございます.右から左に情報が抜けていく中の人が最近見て良かったなって思えた動画はこちら『【鏡の世界では物理法則がわずかに変化する】ハーバード大学物理博士課程・久保田しおん/私たちが消えずに存在している理由を探る/ […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

オン, お話, クロスディグ, こちら, サン, そう, タチ, チャンネル, トーク, トリノ, ニュー, バー, パート, わけ, 世界, 久保田, 動画, 勝算, 博士, 圧倒的, 変化, 大学, 存在, 対称, 専門, 情報, 明日, 最近, 有料, 法則, 物理, 理由, 理解, 登録, 相手, 研究, 競合, 能力, 表面, 課程, 転換,

映画、アンチャーテッドを観ました。 #映画レビュー #遅ればせながら感想

2022.10.29

おはようございます、何をもって仕事とするかが曖昧になっている気がします。 さて、今日はアマプラでアンチャーテッドを遅ればせながら観ましたので感想を残しときます。この映画は簡単に言えば冒険活劇的な映画です、インディーズの現 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

アマ, アンチャーテッド, インディーズ, キャラ, ゲーム, こと, ストーリー, そこ, ナゾッ, ネタ, プラ, レビュー, 一苦労, 予備知識, 今日, 仕事, 何, 全体, 冒険, 制作, 前提, 割愛, 専門, 少し, 展開, 感想, 映画, 曖昧, 残念, 気, 活劇, 現代, 画面, 簡単, 級, 結果, 自分,

尺が短いものが好まれる時代、分かった気になる情報😇。

2022.08.04

おはようございます、Githubのマルウェアが気になって早朝に情報をチェックしていました。 さて、今の時代、尺が短いものが好まれる時代、分かった気になる情報が世の中に受け入れやすくなっているような気がします。敢えて分厚い […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

github, YOUTUBER, いろいろ, おすすめ, かなり, それ, チェック, ツマミ, つまみ食い, ところ, ニッチ, ブログ, マルウェア, もの, 上質, 世, 中, 中身, 事, 人, 今, 価値, 分, 到達, 努力, 動画, 収集, 大事, 専門, 専門家, 尺, 情報, 所, 方, 早朝, 時代, 本, 本末転倒, 次第, 殆ど, 気, 発信, 知識, 結局, 表面, 部分, 長文, 難解,

アクセス数と収益は必ずしも比例しない。ミスマッチな○×。

2022.07.08

おはようございます、今日は週末ですね?、来週の今頃は今の会社を退社している。 さて、タイトルにも記載した通りアクセス数と収益は必ずしも比例関係にありません。そういうことなので自分のブログはそれなりに収益化出来ています。収 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

○×, アクセス, いくつ, うち, こと, それ, それなり, タイトル, ため, ツール, どれか, ブログ, プログラミング, マッチ, ミスマッチ, もの, ユーザー, 一つ, 今, 今日, 今頃, 会社, 傾向, 分野, 制作, 収益, 基, 専門, 広告, 成功, 投資, 映画, 来週, 横ばい, 比例, 為, 無料, 特化, 自分, 表示, 記載, 退社, 通り, 週末, 関係, 頃,

悪い円安とか言われているので、下がり具合を見てみた。

2022.05.16

おはようございます。 この頃、悪い円安とか言われているので、下がり具合を見てみました。見てみると結構下がっているのがわかります。 過去5年間でみると物凄く下がっていますよね。海外へ旅行へいくと物価が3倍だとか呟いている人 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

20, 3, 5, iPhone, こちら, サイト, スマホ, ファイナンス, 万, 不安, 人, 人口, 値段, 具合, 円安, 労働, 対応, 専門, 将来, 政府, 旅行, 日本, 気, 海外, 物価, 生産性, 給与, 自分, 過去, 頃, 駄目,

映画、99.9-刑事専門弁護士-THE MOVIEを観てきましたよ。

2022.01.04

映画、99.9-刑事専門弁護士を観てきましたよ、率直に感想を述べると案外良かった。因みに自分は「 99.9-刑事専門弁護士 」のドラマも観たことがない、映画予告も観ずに観に行きました。おやじギャグのナンセンスなギャクを連 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

99.9, MOVIE, The, おやじ, かなり, ギャグ, こと, ストーリー, ため, ドラマ, ナンセンス, まし, ラスト, 世界観, 中, 予告, 人, 何, 何度か, 刑事, 場面, 専門, 弁護士, 必死, 感想, 映画, 映画館, 最後, 注目, 独特, 率直, 的, 真実, 空気感, 笑い, 自分, 連発, 静けさ,

XXXXPICKSを有料会員から無料会員にした訳。

2021.04.16

サブスクリプションを見直すにあたって先日、ニューズピックスを有料会員から無料会員にしました、解約した理由は、先ず(まず)1500円という価格が今の自分には勿体なと感じました。なぜ勿体ないなと感じたか、それはニューズピック […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

1500, newspicks, XXXXPICKS, youtube, おっさん, こちら, こと, サーフィン, サブスクリプション, それ, ニュース, ネット, ビジネス, ピックス, マンネリ, メディア, 事, 今, 会, 会員, 何故, 価格, 先日, 全部, 動画, 専門, 意識, 有料, 枠, 毎回, 毎日, 無料, 物, 理由, 番組, 系, 自分, 良質, 要因, 視聴, 解約, 記事, 訳,

みんな知らないが当たり前だということを忘れる。

2021.02.02

知っている人はみんなも知っているという感覚がある、たぶん専門分野をお仕事にしている人が知らない人と会話するときに相手と歪みが生まれたりしますよね。じぶんもこの頃、それがたまにあります。 知らないがあたりまえだと思って話す […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

アタリマエ, いろいろ, お仕事, こと, じぶん, それ, たま, とき, みんな, 人, 会話, 作業, 分野, 大変, 専門, 当たり前, 感じ, 感情, 感覚, 歪, 相手, 表現, 記録, 頃,

大量アクセス元&高知&鳥羽&専門校

2018.02.22

大量アクセス元&高知&鳥羽&専門&端末。 Not Foundのページに大量アクセス。

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が30代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

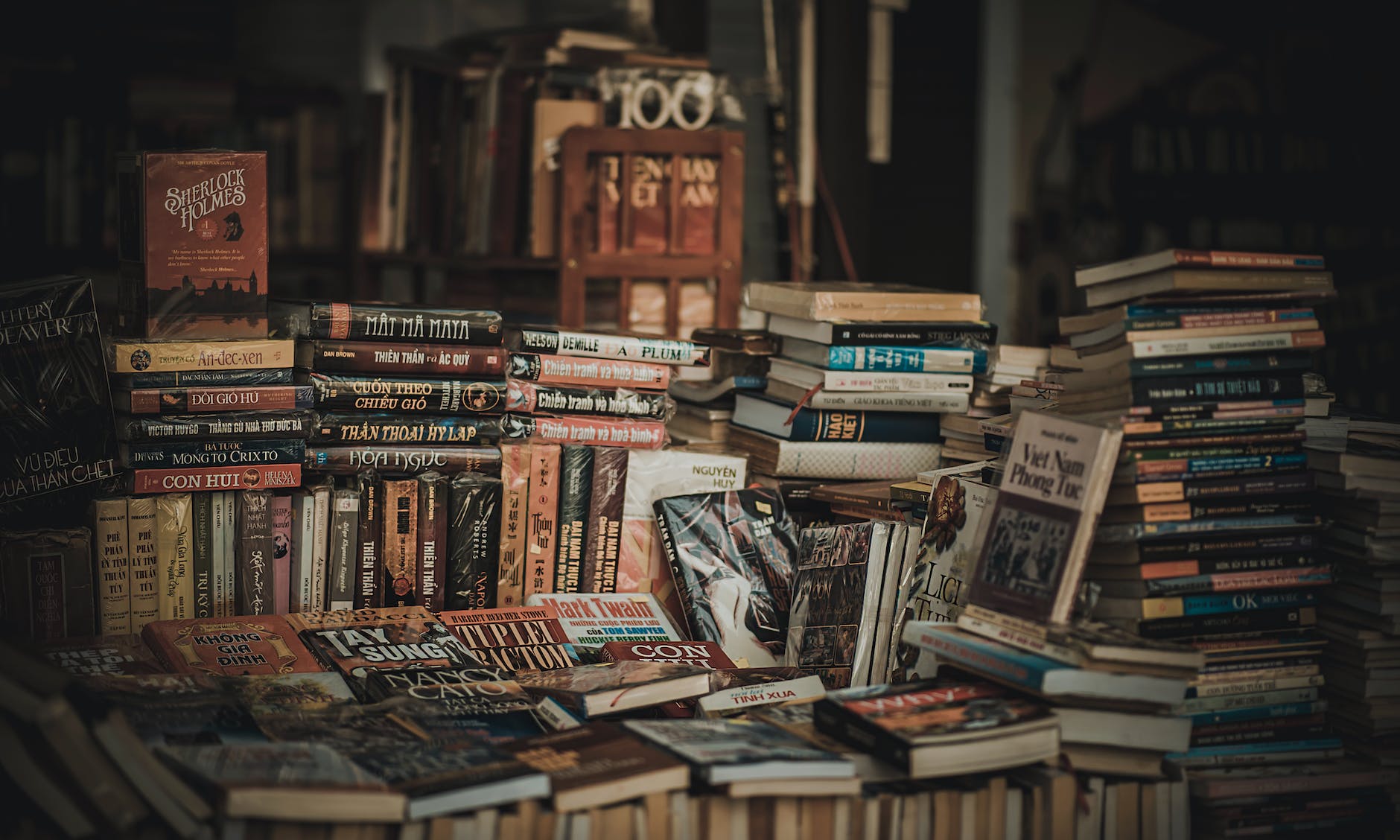

高知県朝倉の金高堂書店が良い感じです。ただ遠いのが難。

2016.02.12

高知県朝倉の金高堂書店が良い感じです。ただ遠いのが難ですね。それ以外は全然、OKな感じです。本のジャンルも結構有ったりして良い感じです。昔、宮脇書店は2Fに専門書コーナーがあったので結構、お世話になりましたが数年前からゲ […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が30代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

お世話, ゲオ, コーナー, こちら, ジャンル, そう, それ, だだ, よう, 以外, 場所, 大谷公園, 宮脇, 専門, 感じ, 書店, 朝倉, 目安, 金高, 間借り, 高知,