story of my life

過去の蓄積を見るために書く日記.

Qiitaを復活させたのは転職活動の一部です.復活させるとは思わなかった

2025.10.18

おはようございます.Qiitaを復活させたのは転職活動の一部です.復活させるとは自分でも思わなかったですが背に腹は代えられないので、復活しました. コードを読み込ませてドキュメントを書いてもらうのが今の自分のスタイルです […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

~!!, AI, qiita, いっかん, コード, スカウト, スタイル, すべて, ドキュメント, ひと, フルリモートワーク, レベル, 一部, 上記, 偏差, 停止, 判定, 削除, 地元, 希少, 底辺, 復活, 抵抗, 掲載, 明日, 時給, 本当, 活動, 自分, 苦手, 記事, 設定, 転職, 通り, 通勤, 閉鎖,

AIで記事を学習して新たな記事を生み出すにはお金が必要だと思っていたがそうでも.

2025.06.22

おはようございます.AIで記事を学習して新たな記事を生み出すにはお金が必要だと思っていたがそうでもなくローカルPCでそこら辺に落ちているLlamaモデルを持ってきてチューニングすれば何とかなるじゃねぇという思いに至った. […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

```, ;;), )。, アウト, アシスタント, アダプター, あたり, アップ, あなた, いくつ, ウォーム, エポック, エラー, エントリ, オープン, オプティマイザ, お金, クラウドサービス, グループ, クン, ゲーミング, コード, コア, ここ, こと, コミュニティ, コメント, これ, サイズ, サンプリング, サンプル, シーケンス, スクリプト, スケーリング, スケジューラー, スタイル, ステップ, スペック, すべて, ソース, そこら, タイプ, ダウンロード, タスク, ため, チューニング, ツール, データ, データセット, テーマ, ディレクトリ, テキスト, デバイス, デフォルト, トー, トークナイザー, とき, どれ, トレーナー, ドロップ, バイアス, パス, バッチ, パディング, パラメータ, バランス, ファイル, ファイルサイズ, ファインチューニング, ファインチューニングコード, フリーズ, プロ, プロンプト, マシン, マッピング, メモリ, モード, モデル, もの, ユーザー, よう, ライター, ライブラリ, ラベル, ランク, リモート, レベル, レポート, ローカル, ロード, ログ, 一般, 一部, 上記, 不要, 世界, 世界中, 並み, 並列, 予算, 付与, 以下, 以降, 企業, 使い, 使用, 係数, 保存, 個人, 優秀, 入力, 公開, 共有, 具体, 処理, 出力, 分割, 分散, 分野, 初期, 利点, 利用, 制御, 削減, 削除, 創造, 加速, 助け, 効率, 動作, 勾配, 十分, 参考, 反映, 可能, 向上, 味方, 因果, 場合, 多様, 夢物語, 大幅, 大量, 失敗, 学習, 完了, 完全, 完璧, 実現, 実行, 実質, 寄与, 対応, 専門, 導入, 少量, 工夫, 希望, 常識, 強力, 形式, 必要, 思い, 性能, 手元, 手法, 技術, 抜群, 指定, 指示, 挿入, 推奨, 推論, 提供, 整形, 新た, 方法, 日々, 明日, 明確, 明示, 時代, 時間, 最大, 最新, 最適, 有効, 未知数, 本格, 格段, 格納, 構築, 様々, 比率, 民主, 活用, 活発, 消費, 混合, 済み, 温度, 準備, 無効, 無料, 特定, 特権, 現実, 理由, 環境, 生成, 発生, 登場, 的確, 相性, 短時間, 確認, 秘訣, 移動, 程度, 管理, 節約, 精度, 終了, 結合, 結果, 続行, 能力, 自体, 自分, 自動的, 蓄積, 表現, 言語, 計算, 記事, 設定, 許可, 調整, 費用, 軽量, 追加, 通常, 適用, 選択, 重み, 重要, 量子, 開始, 開発, 関数, 閾値, 非常, 高速, 高額, 魅力,

15分、本を読む時間を作ろうと思っています.積本消化していこうと.

2025.06.19

おはようございます.読書は、知識を深め、視野を広げ、心を豊かにしてくれる素晴らしい習慣です。たった15分でも、毎日続けることで多くのメリットがあります。 なぜ15分なのか? 15分という時間は、忙しい日々の中でも比較的確 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

こと, ジャンル, スタイル, ストレス, スマート, スムーズ, タブレット, ため, とき, ところ, ヒント, フォン, メリット, モチベーション, よう, 一つ, 一時, 内容, 効果, 向上, 場所, 多く, 大体, 大切, 好き, 定着, 感想, 手軽, 提示, 文章, 日々, 明日, 時間, 書籍, 朝食, 期待, 様々, 毎日, 没頭, 活用, 消化, 無理, 現実, 知識, 短時間, 確保, 継続, 習慣, 自分, 自然, 興味, 表現, 視野, 語彙, 説明, 読了, 読書, 豊か, 軽減, 通勤, 隙間, 集中, 電子, 電車,

オモロイからやってんねん、出来ることからすれば良い.

2025.05.08

おはようございます.GW期間中に何度かUPしましたが自分で動画を作るのはオモロイ.そして人工知能を使った対談もオモロイです.いま情報源を読み込ませて音声を作っているのですがここから修正したりすることや色を付ける修正が出来 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

いま情報源, オモロイ, オリジナル性, スタイル, タイミング, チャンネル登録数, ボイス, マイク, 人工知能, 何度, 修正, 再生回数, 動画, 収益化, 声, 対談, 色, 通り何処, 音声, 顔,

一人の天才というよりは流れを作るのが上手い人なのかもしれない.

2024.09.05

おはようございます.チームラボ代表猪子寿之 氏は東大卒の人だけど、一人の天才というよりは流れを作るのが上手い人なのかもしれない.猪子寿之 氏は小さなWEB会社から始めていまでは世界で活動する会社になった元を作ったひと. […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

WEB会社, スタイル, チームラボ代表猪子寿之, ひと, ひと., 一人, 上手い人, 世界, 人, 人間味あふれる人, 会社, 元, 友, 天才, 昔, 東大卒, 猪子寿之, 類,

通称デデデデ映画化。

2024.02.03

おはようございます、YOUTUBEのおすすめに浅野いにおさん原作の『デッドデッドデーモンズデデデデデストラクション』の映画予告が表示されたので見てみた。予告だけでどうなるだろうと展開が気になる内容だった。 『デッドデッド […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

youtube, おさんファン, おさん原作, コンビニ, スタイル, デッドデッドデーモンズデデデデデストラクション, フルリモート, 予告, 休み, 原作, 家, 展開, 映画予告, 映画化, 映画観, 浅野い, 漫画, 知識, 立ち読み, 辛口評価,

FF7Rをやっとクリアした。何年まえに

2023.12.10

おはようございます、FF7Rをやっとクリアした。何年まえに発売したんだったけっと調べてみると2021年の6月10日に発売された事がわかった。発売されてから2年間とちょっとの月日が経過してやっとクリア一回目というのは、普通 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

2年間, 6月10日, FF7R, FF7リバース, PS5, クリア一回目, ゲーム, スタイル, ところ, ひとりツッコミ, 人, 何年まえ, 感じ, 早い方, 月日, 次, 気, 自分, 遅い, 部分,

chatGPTを使用していますか。”YesOrNo”

2023.02.28

おはようございます、chatGPTをお仕事でも活用しています。 例えば「Bootstrapで下記の情報(単語一覧)を使用してフォームを構築して」と指示すると、コーディングしたBootstrapの雛形を生成してくれます。な […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

Bootstrap, ChatGPT, コーディング, コーディングスタイル, コード, スタイル, その他, タスク量, フォーム, 一度, 下記, 効率, 単語一覧, 小出し, 指示, 最初, 現段階, 途中, 雛形, 項目数,

もう更新されていない「かめっちTV」の対談を見て思うこと。

2022.01.17

昨日の夜中、トンガで火山噴火があり夜中に津波警報で起こされました。高知県の漁港でも船が流されたりして被害があったようです。 さてYOUTUBEチャンネル「かめっちTV」ですが、二年前から全然更新されていないチャンネルです […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

8, CEO, DMM, TV, youtube, うち, カメ, きっかけ, こと, スタイル, チャンネル, トンガ, メタップス, 亀山, 事, 二, 二人, 人, 人間味, 会長, 佐藤, 先見, 判断, 動画, 噴火, 夜中, 対談, 思考, 思考法, 昨日, 更新, 最後, 未来, 本, 津波, 漁港, 火山, 眼, 航, 船, 被害, 誰, 警報, 購入, 陽, 高知県,

ブログの形を少し変えようかなとか思いつつも今まで通りか?。

2021.11.01

ブログの形を少し変えようかなとか思いつつも今まで通りの近況スタイルで記事を書いていきます。もうこのブログ、書き出してから7年ぐらい経過していますね。書き出した当初は若気の至りみたいな文章だといま読み返すと思います。黒の歴 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

20, 7, アクセス, アニメ, いま, これ, サイト, スタイル, スタジオ, バレ, ブログ, 七, 今, 何度, 出版, 前半, 少し, 当初, 形, 意味, 文章, 断トツ, 時, 時期, 更新, 最後, 本, 歴史, 経過, 絵日記, 自分, 若気, 記事, 訪問, 証, 身, 近況, 通り, 頻度, 黒,

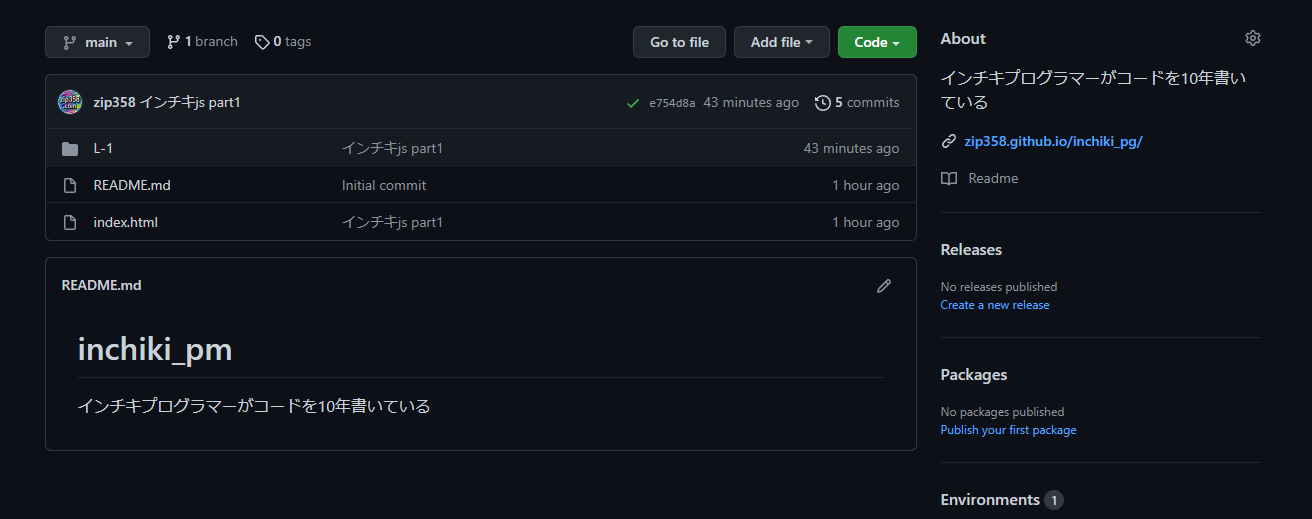

プログラム言語レッスン動画じゃない緩いやつ始めます。いやハジメマシタ!!

2021.10.25

プログラム言語レッスン動画じゃない緩いやつ始めます。YOUTUBEでむかし、ズブズブなPHP言語レッスン動画をUPしていました、今回は音声説明も何もないダダ、コードを書いている緩い動画を日々UPしていきます。動画に音楽を […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

10, 2, com, github, https, if, php, Qq-ctgcMRWQ, UP, watch, www, youtube, コード, サンプル, スタイル, ズブズブ, ソース, その他, タイトル, だだ, チャンネル, トイウコトデ, ネタ, ハジメマシタ, ブログ, プログラム, むかし, やつ, レッスン, 下記, 今, 今回, 何, 使用, 初回, 動作, 動画, 文, 日々, 概要, 解説, 言語, 記事, 説明, 音声, 音楽, 頻度,

少しjava言語を勉強中。自分の勉強方法はこんな感じになります。

2021.08.18

最近、雨が続いていてあの暑さを忘れかけていますが、いま夏なんですよね。。。天気が回復したら空の良い写真が取れそうな気がします。 さて、先日からjava言語をまともに勉強しだしました、アプリ制作をしながらjavaに触れよう […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

java, php, アプリ, いま, オブジェクト, かなり, こと, これ, スタイル, そちら, とき, ネット, まとも, 今更, 他, 先日, 写真, 制作, 勉強, 参考書, 回復, 基本, 夏, 天気, 実際, 少し, 応用, 感じ, 所, 手, 指向, 方, 方法, 最初, 最後, 最近, 正直, 気, 王様, 空, 自分, 言語, 近道, 重要, 雨, 頃, 題,

教養としての投資の奥野 一成さんの語りが良い感じ。

2021.08.01

8月になりましたね。今頃、未来の自分は何をしているのかなぁなどと思いながら記事を書いています。 今回はVR教養としての投資の奥野 一成さんの語りが良い感じですって話です・・・(*´ω`*)、4000億円を動かす男が語る動 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

4000, 8, BIZ, Vr, youtube, おすすめ, こと, スタイル, それ, チョイス, テレ東, ナイス, バフェット, 一成, 事, 人工, 今回, 今頃, 何, 何気, 億, 前半, 前置き, 動画, 太っ腹, 奥野, 孫, 後半, 感じ, 感想, 投資, 教養, 未来, 深堀, 男, 番組, 知能, 素人, 自分, 記事, 話, 頃,

宇宙旅行が現実になるにはあと30年ぐらい時間が必要だと思う。

2021.07.27

先週は2記事しか投稿していないですね(*´ω`*)すみません。今週から土日祝も記事を投稿するスタイルに戻します。 宇宙旅行が現実になるにはあと30年は必要だと思う、これはある意味直感的なものなので実際はもっと早く一般人で […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

10, 2, 20, 30, アマゾン, いま, こと, これ, ジェフ, スタイル, ベゾス, もの, 一, 一生, 一般人, 事, 事業, 今週, 他, 体験, 先日, 先週, 創業者, 土日, 地球, 子供, 存在, 宇宙, 宇宙旅行, 実際, 富裕層, 帰還, 後, 必要, 惑星, 意味, 感じ, 感覚, 投稿, 日, 時間, 月, 未来, 東京, 火星, 現実, 祝, 記事, 資源, 重力, 開拓者,

あれこだよ。前からあったけど、これからこれだと思った件。

2021.02.15

これからは、N高みたいな時代になっていくだろうと思います。時代は変わると思います、勉強はさせられるものじゃなく、するものだという考えを持っている学生にとってはN高はとても良い環境なんだろうと思います、そしていじめられてい […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

あれ, コ, これ, スタイル, もの, 今週, 件, 前, 勉強, 卒業, 子, 学生, 時代, 来週, 物事, 環境, 短文, 資格, 高, 高校,

ping送信はエラー吐きまくり。

2020.11.03

上記のようなping一覧が在るけれど、実際機能していないものが多い。ping送信はもう時代遅れになりつつ在るのかもしれない。そんな時代遅れになりつつ存在なので、自分でping先をいちいち管理するのは、ナンセンスだと思いこ […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

2, Amagle, blog, BLOGGERS, bolgoon, BulkFeed, cocolog-nifty, com, fc, goo, http, https, JAPAN, jp, JUGEM, MyBlog, NAMAAN, People, ping, pingoo, service, Technorati, xmlrpc, Yahoo, いろいろ, エキサイト, エラー, ココログ, サーバー, サービス, スタイル, スパム, ドリコム, ナンセンス, プラン, フリー, ブログ, ブログ村, もの, ランキング, 一覧, 上記, 人気, 先, 存在, 実際, 広場, 度, 方々, 時代遅れ, 機能, 登録, 管理, 自分, 送信,

いや良いだけどちょっと悔しい。

2020.10.20

NewsPicksの社員さんと地方のITエンジニアさんとのお給料を考えたときにちょっと悔しいなと思いました、いやお金じゃないだけど・・・ちょっとお給料のことがヨギリマシタよ。 フル視聴はこちら https://newsp […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

907, com, https, IT, live-movie, newspicks, Python, VBA, あと, エクセル, エンジニア, お給料, お金, かなり, グーグル, こちら, こと, これ, シート, シタ, スタイル, スプレッド, とき, ネット, プル, マクロ, ヨギ, りま, 一般人, 事務, 作業, 使用, 全て, 共有, 効率, 動画, 地方, 基本, 必要, 操作, 方, 普通, 気, 直ぐ, 社員, 答え, 簡単, 自分, 視聴, 解決, 関数,

text形式に土日は変更。

2020.10.03

土日は基本テストスタイルに変更しようと思っています。なお、今まで土日はイラストを挿絵としていれておりましたが、サーバー移行の際に画像データがすべて消えてしまったことにより、この際、テキスト形式にしようと思ったので、そのよ […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

567, Text, イラスト, お休み, お話, こと, サーバー, スタイル, すべて, データ, テキスト, テスト, リスク, 予告, 事, 土日, 基本, 場合, 変更, 完璧, 密室, 形式, 感動, 挿絵, 映画, 映画館, 本当, 本数, 本日, 気, 気持ち, 浅田家, 画像, 短文, 移行, 空調, 結構, 記事, 設備, 際, 高知県,

秋ですよ、秋ですよ。パーカー!

2020.09.26

秋ですよ、秋といえばパーカーです、YOUTUBERパーカーさんとは関係ありませんが動画を貼っときます。さて秋といえば上着はパーカーかジャージ上が秋の基本スタイルのコーディネートスタイルです(暑い日はポロシャツですが)。オ […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

YOUTUBER, オシャレ, コーディネート, こと, し, ジャージ, スタイル, セーター, それ, デザイン, パーカー, ポロシャツ, ロゴ, 上着, 今年, 写真, 冬, 動画, 基本, 夏, 日, 時, 時代, 洋服, 無地, 秋, 絵柄, 進化, 過去, 関係,

自戒の念を込めて不景気になるって事。

2020.05.09

不景気になるとどうなるのか。 占い師が儲かる。自己啓発本が売れる。派遣や転職サイトへの登録者が増える。格差が広がる。失業者が増える。国の借金が増える。勧誘が増える。儲け話が横行する。ブラック企業が増える。等など いま、5 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

567, アレ, いま, いろいろ, インカム, かなり, こと, サイト, スタイル, どれ, ネット, ブラック, ベーシック, 不景気, 世, 中, 予想, 事, 人, 今後, 企業, 何気, 借金, 儲け話, 判断, 力, 勧誘, 占い師, 反対, 啓発, 回復, 国, 基準, 失業, 失業者, 存在, 念, 情報, 意図, 意見, 政府, 政治, 日, 日本, 時間, 本当, 格差, 検討, 業界, 横行, 気, 派遣, 発言, 登録者, 等, 自己, 自戒, 言葉, 話, 転職,

YOUTUBER貞山放送鉄生(ていざんほうそうてつお)さん

2020.05.06

貞山放送鉄生さんの職業は運送を行っているトラックドライバーさんです、ですと言えばよいかわからないけど、567の事がありこれからはYOUTUBERが本業になりそうなそんな予感さえする方です。トラックドライバーとの接点があっ […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

20, 40, 567, 7, com, https, J-nA, TSi, watch, www, youtube, YOUTUBER, お話, こと, これ, スタイル, そのまんま, チャンネル, ていざん, てつお, とき, ドライバー, トラック, ほうそう, 一線, 予感, 事, 人, 他, 前半, 勝手, 印象, 増, 所, 接点, 放送, 方, 最初, 本業, 登録, 職業, 自分, 親近感, 貞山, 輸送, 途中, 運, 運送, 部屋, 鉄生, 頃,

inliving=いん りびんぐと読みます。

2020.03.15

いんりびんぐ(ririka / vlog)さんのvlogです。中堅YOUTUBERというあたりのポジションかなと思います。ちなみに自分が知った頃はもっと登録者数は少なかったように覚えています。このひと、数年前からYOUT […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代前半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

htt, inliving, ririka, UNIQLO, Vlog, youtube, YOUTUBER, あたり, いろいろ, いん, がいそう, ぐ, コーディネート, こちら, これ, ショップ, スタイル, センス, チャンネル, どちらか, ひと, プロ, ポジション, メディア, りびん, レベル, 中堅, 人, 何, 大変, 女性層, 数, 敵, 最後, 有名, 本人, 気, 無印良品, 理由, 男性層, 登場, 登録, 登録者, 自分, 運営, 頃, 顔,

時間革命 1秒もムダに生きるな:著 堀江貴文

2019.12.03

時間革命 1秒もムダに生きるな:著 堀江貴文この本の中に自意識が描き出す「世間」は、心のなかの幻であるという言葉が書かている。これ、まったくその通りだなと思います。ひとは想像の中で生きている生き物だと自分は思っていてひと […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が30代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

1, こと, これ, スタイル, チャット, ところ, なか, ひと, ムダ, ログ, ワーク, 一貫, 世間, 中, 事, 人, 今, 仕事, 他人, 出版, 堀江貴文, 幻, 心, 必要, 想像, 所, 時間, 最低限, 本, 気, 理由, 生き物, 自分, 自意識, 著, 言葉, 通り, 電話, 革命,

「2030年世界はこう変わる」をパラ読みして。

2015.10.05

「2030年世界はこう変わる」をパラ読みしてこう変わるじゃなくて、こう変えたいような気がしてきた。確かにいろいろなパターンや未来予測がかかられているがアメリカは世界をこう変えたいのだろうという節が何点かあった。おそらく雇 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が30代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

2030, アメリカ, いろいろ, こと, シフト, スタイル, トイウヨリ, パターン, フリー, ランス, 世界, 中, 予測, 人, 今後, 企業, 何点, 個人, 働き方, 共通, 共通点, 唯一, 地方, 変化, 差, 形態, 未来, 本, 気, 節, 都市, 雇用,