story of my life

過去の蓄積を見るために書く日記.

漠然たるものを形にするのがクリエイターの仕事

2025.12.26

おはようございます、クリエイターとアーティストの違いは何かと言えばクリエイターはお客様の漠然したものを聞き取ってある一つの形にするのがクリエイターである、ではアーティストとは何かと言えば自分の伝えたいものをアートを通じて […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

アーティスト, アート, お客様, お金, クリエイター, クリスマスイブ, コード, こと, これ, シバ, それ, デザイン, どちら, プログラム, ホーム, もの, 一つ, 仕事, 何処, 境地, 好き, 彼女, 思い, 思考, 意味, 感覚, 明日, 満足, 漠然, 発信, 自分, 自己, 行為, 追伸, 違い,

ポップアートと生成AIとAIで思ったこと.

2025.12.25

おはようございます、ポップアートを生成AIと共にAI(イラレ)で作ることが楽しいのですが、実際は自分で一から作りたいなという思いがあります. 自然言語で指示すればそれなりのモノがイラレでも出力されるようになってきました. […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

AI, イラレ, クリエイター, クリエイティブ, コード, こと, これ, サン, そう, それ, それなり, とき, ところ, ナノ, バナナ, フォトショ, プロ, ポップアート, もの, よう, 一番, 一部, 人間, 作品, 使用, 修正, 出力, 問題, 境界, 売れっ子, 完璧, 思い, 感じ, 成果, 技術, 指示, 明日, 時代, 最新, 状況, 生成, 精度, 素人, 脅威, 自分, 自然, 言語, 面白み,

映画アバターを観てきました.今年最後の映画見納め

2025.12.24

おはようございます.映画アバターを観てきましたので感想を残しときます.映画アバターの三部作になる「アバター ファイヤー・アンド・アッシュ」を観たのですが、どうもコレで完結の予感がしますと言うか終わり方だけ言えば完結です. […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

Cg, VFX, アバター, アメリカ, いた事, お客, こと, これ, コレ, サン, ストーリー, それ, ツッコミ, ところ, ファイヤー・アンド・アッシュ, メッセージ, ラスト, ワンパターン, 予感, 余計, 全作, 印象, 同じ, 圧巻, 大事, 完結, 展開, 感想, 感覚, 技術, 明日, 映画, 時間, 最初, 確か, 素人目, 自分, 表現, 追記, 過去, 長丁場, 限り, 集中,

田舎の公共交通機関がズタボロ感.皆さん使いませんか?

2025.12.23

おはようございます.田舎の公共交通機関がズタボロ感を先日国家試験を受けに市内まで行っていた時に感じました.高知市まで行く便の運賃が以前より30円ぐらい値上げされていて愕然となりましたが、、、 これは仕方がない事だけど、や […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

JR, アクシデント, お昼, コチラ, これ, ご飯, ズタボロ, そこ, ため, ネット, パス, メリット, よう, 不便, 交通, 仕方, 以前, 使用, 値上げ, 先日, 公共, 割合, 国家, 土佐, 土日, 市内, 後免, 愕然, 明日, 時刻, 時間, 機関, 次第, 活用, 田舎, 県庁, 県民, 確か, 社会, 移動, 終了, 自分, 試験, 路線, 運賃, 過ぎ, 電車, 高知,

さくらレンタルサーバーデータベースをフルバックアップするコード

2025.12.20

おはようございます.アバターは月曜日か火曜日に観に行くつもりでいますがどうなるかは未定です.本日はさくらレンタルサーバーデータベースをごっそり定期的にフルバックアップするコードを作成したのでその話を書いていきます.このコ […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

www, アップ, あと, アバター, エラー, クロン, コード, コマンド, コメント, これ, これら, ころ, さくら, そこ, つもり, ところ, パスワード, バックアップ, フルバック, ユーザー, よう, ライン, レンタルサーバーデータベース, 不要, 作成, 使用, 出力, 削除, 可変, 国家, 場合, 変更, 定期, 実行, 必要, 明日, 月曜日, 未定, 本日, 注意, 火曜日, 環境, 県庁, 結果, 結構, 自由, 自身, 設定, 試験, 辺り, 追伸, 重要, 高知,

アクセスカウンターはSQLiteとPHP言語で出来ています.

2025.12.19

おはようございます、このサイトのアクセスカウンターはSQLiteとPHP言語で出来ています.ボット訪問者はカウントしないなどは別のプログラムで制御しています.そういう訳もあって結構シンプルなコードで出来上がっていると思い […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

IP, MaxMind, php, Sqlite, アカウント, アクセス, アナリティクス, カウンター, カウント, コード, こと, これ, サーバー, サイト, しょう, シンガポール, シンプル, そこ, それ, ダウンロード, データベース, プログラム, ボット, よう, ライブラリ, 一番, 中国, 何処, 使用, 判別, 判定, 制御, 可能, 必要, 方法, 明日, 海外, 登録, 簡単, 経由, 自分, 規約, 解析, 言語, 訪問, 負荷, 遮断, 非常,

民衆も国もいま忘れていること.平和が一番だという当たり前のことを

2025.12.18

おはようございます.民衆も国もいま忘れていること.平和が一番だという当たり前のことを忘れている、いまの日本のメディアも一歩引いた情報統制をしてほしい.中国の挑発に乗っているのと同じ事、エスカレートして何でもかんでも国民を […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

いま, エスカレート, こと, これ, すべ, それ, マスメディア, メディア, よう, 一番, 不幸, 中国, 健康, 先見, 内容, 原因, 国民, 好き, 平和, 幸せ, 引用, 当たり前, 情報, 戦争, 挑発, 政治, 日本, 明日, 本気, 正直, 民衆, 病気, 立振舞, 統制, 自分, 菜根, 言葉, 謝罪, 賢人, 長生き,

未来予想したかったら米国と中国を見よ.

2025.12.16

おはようございます.未来予想をする前に米国で起きたことは10年内に日本でも起こる出来事であることです.だいだい都市からそういう技術的なことが取り入れて地方都市、地方と侵食されていく.高知県はそういうのが一番遅いのでだいぶ […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

あたり, ウクライナ, オーダー, こと, これ, コンピューター, そう, それ, それら, だいたい, どちら, トランセンデンス, ネタ, メイド, よう, ラスト, ロシア, ロボット, 一番, 予想, 人工, 今後, 仕事, 以上, 侵食, 再現, 再生, 出来事, 可能, 地方, 大丈夫, 妄想, 将来, 年内, 急速, 情報, 感じ, 戦い, 戦争, 技術, 日本, 明日, 映画, 未来, 本題, 来年, 機能, 殆ど, 治療, 病気, 知能, 研究, 確率, 米国, 精神, 結果, 老化, 自動, 若返り, 解明, 身体, 追伸, 進化, 運転, 都市, 防止, 障害, 高知,

恒例のカウントダウンをお裾分けと試験日の話

2025.12.15

おはようございます.恒例のカウントダウンをお裾分けと試験日の話を書いていきます、まず恒例のカウントダウンを作りましたのでお裾分けです、ソースコード確認やcloneしたい方は下記のリンクより参照して下さい. https:/ […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

CLONE, gistgithubcomtaokacabccedddafd, https, いま, お裾分け, お話, カウントダウン, ヶ月, コード, こと, これ, ソース, そう, それ, だいたい, つもり, まし, まま, リンク, 一つ, 下記, 予定, 今回, 今週, 勉強, 参照, 受験, 可能, 合格, 国家, 土壇場, 土曜日, 場合, 就職, 延期, 恒例, 折り合い, 明日, 来年, 目安, 確認, 自分, 記事, 試験, 調子, 資格, 週間, 過去, 駄目,

選択した文言から自動的にハッシュタグを生成する Chrome 拡張機能

2025.12.08

おはようございます.選択した文言から自動的にハッシュタグを生成する Chrome 拡張機能を作りました、特に申請していないので公式サイトから使用できる訳では無いですが、Github上にパブリックで公開しているのでローカル […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

Chrome, github, https, LM, OpenAI, qiita, qiitacomtaokatoshiakiitemsaecedb, SNS, Studio, いろいろ, インストール, こと, これ, サーバー, サイト, そう, タグ, ところ, ハッシュ, パブリック, ポスト, マーケティング, みたい, モデル, ユーザー, リンク, ローカル, 乱用, 使用, 便利, 公式, 公開, 前提, 回数, 外部, 拡張, 推奨, 文章, 文言, 明日, 最後, 最終, 有効, 条件, 機能, 生成, 申請, 結局, 自分, 自動的, 表示, 記事, 選択,

PHP言語のescapeshellargが良かった.

2025.12.07

おはようございます.前々から気になっていた、escapeshellargという関数の説明をAIに解説と主観を書いていきます. PHP の escapeshellarg() とは何か escapeshellarg() は、 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

```, AI, escapeshellarg, escapeshellcmd, php, エスケープ, クォート, ググ, コード, こと, コマンド, これ, これら, シェル, シングル, セキュリティ, それ, ドラゴン, ボール, メンター, よう, ライン, レビュー, 主観, 仕事, 以前, 使用, 個人, 具体, 内部, 前々, 危険, 吸収, 囲み, 地方, 変換, 安全, 感じ, 払拭, 教え, 文字, 明日, 時間, 独学, 現場, 環境, 登場, 知識, 短縮, 空白, 自分, 解説, 言葉, 記号, 説明, 部屋, 関数, 難点,

感覚と現実は違うだということが分かっていても.

2025.12.05

おはようございます、感覚と現実は違うだということが分かっていても人は感覚を優先しがちになるという事を淡々と書いていきます.自分は出来ると思っていても実際に行動してみると出来ないことが多々あるということ. 良くあるのが水泳 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

いろいろ, ガタ, ガチ, ケース, こと, これ, コレ, そこ, それ, とき, バグ, よう, 上書き, 不摂生, 事故, 体験, 健常, 優先, 場合, 大事, 失敗, 学生, 感覚, 明日, 水泳, 現実, 病気, 発生, 自分, 行動, 運動,

laravelとReactとviteの話です.ローカルサーバーを建てず

2025.11.29

おはようございます.laravelとReactとviteの話です.ローカルサーバーを建てずに直本番にアップロードしてテストしたいなど、こんな場面はあまりないとは思いますが出先でひ弱なPC環境だった場合.Dockerなどを […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

docker, Laravel, nodejs, npm, PC, react, vite, アップ, インストール, ウェア, グローバル, ここ, こと, これ, サーバー, サービス, システム, ディレクトリ, テスト, ノード, パソコン, パッケージ, パブリック, ビルド, ひ弱, ファイル, まる, モジュール, よう, リスク, ローカル, ロード, 一致, 伝染, 停止, 出先, 前提, 問題, 場合, 場面, 対応, 必要, 意味, 慎重, 手順, 方法, 明日, 本番, 条件, 環境, 確認, 自分, 運用,

無料で観れるシンキングゲームというドキュメンタリー映画が熱い

2025.11.28

おはようございます.無料で観れるシンキングゲームというドキュメンタリー映画が熱いなって思います.映画の最後に無料で公開することに踏み切ったデミス・ハサビス (Demis Hassabis)の決断は称賛しかないと. そして […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

AGI, AI, Demis, Hassabis, youtube, あり方, こと, これ, シンキングゲーム, そう, それ, デミス・ハサビス, とき, ドキュメンタリー, ロボット, 世の中, 世界, 人々, 人工, 人達, 仕事, 公開, 前進, 変化, 宇宙, 方向, 明日, 映画, 最後, 未来, 構造, 決断, 無料, 知能, 社会, 称賛, 能力, 進出,

LM STUDIOとCloudflareを連動させてレンタルサーバーでゴニョ

2025.11.27

おはようございます.LM STUDIOとCloudflareを連動させてサーバー化しレンタルサーバーと連携させればAPIを使わずにSLM(小規模言語モデル)は使える感じですね.ただ自分はこれはちょっと心配なのでまだ試して […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

AI, API, cloudflare, LM, MacMini, SLM, Studio, いま, いろいろ, こと, これ, サーバー, サービス, サイト, セキュア, それ, ため, データ, ところ, トニカク, ホームページ, モデル, リアルタイム, レンタル, ローカル, 今日, 作成, 使用, 処理, 問い合わせ, 実験, 小規模, 心配, 応用, 応答, 感じ, 指示, 方法, 明日, 自分, 自動, 言語, 記事, 購入, 軌道, 返却, 連動, 連携,

みんな知っていると思うけど、もう結構なことが!

2025.11.26

おはようございます.みんな知っていると思うけど、もう結構なことが簡単に生成出来てしまうということを.ChatGPTやGemini(ジェミナイ:ジェミニ)に指示(プロンプト)を出すとそれなりの物が作れてしまうということを. […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

AI, ChatGPT, DeNA, gemini, アップ, あと, アプリ, インターネット, オーダー, コード, こと, コピペ, これ, サーバー, サン, ジェミナイ, ジェミニ, システム, そう, それ, それなり, ツール, テック, ファイル, プログラム, プロンプト, ホームページ, みんな, メイド, メモ, もの, よう, レンタル, ロード, 下位, 仕事, 仕様, 以外, 企業, 作成, 価値, 修正, 内容, 出力, 問題, 大丈夫, 契約, 安泰, 定番, 導入, 当分, 思い, 怪奇, 感じ, 感覚, 指示, 振り, 文言, 日本語, 明日, 時代, 時間, 業界, 構造, 殆ど, 浸透, 物理, 生成, 生業, 登場, 社会, 社長, 簡単, 結構, 自分, 自然, 複雑, 言語, 追伸, 通り, 運用, 金融,

テック業界と一般のひとと近づきあるのかな?

2025.11.21

おはようございます.AI使っている人が増えつつあるとは思うだけど実際どうなんだろう?一般業界の人でAIを使っているひとはどれぐらいいるのだろうかと. AIを使う人が増えてきたらテック業界には結構打撃になる可能性があるなっ […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

AI, ChatGPT, gemini, Sora, UP, UTF-, あたり, アップ, アプリ, カモ, コード, こと, これ, サーバー, ソース, テキストファイル, テック, どれ, ひと, ファイル, ホームページ, みんな, よう, わけ, 一般, 仕事, 作成, 依頼, 傾向, 利用, 動画, 可能, 土台, 変更, 完成, 対応, 打撃, 拡張, 文言, 方法, 明日, 来週, 業界, 殆ど, 減少, 無料, 生成, 画像, 結構, 規約,

出来たけどレンタルサーバー向きではないと思っているけど

2025.11.19

おはようございます.先日の続きの話、出来たけどレンタルサーバー向きではないと思っているけど「仕方がない」.仕方がない理由は処理がサクサク動くAWSサーバーを借りれるほど軍資金もないので、レンタルサーバーでほそぼそと動かそ […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

AWS, あたり, いま, これ, サーバー, サービス, シフト, それ, つもり, トイウワケデ, ほど, よう, レンタル, 一つ, 今週, 仕方, 先日, 処理, 収入, 収益, 向き, 宣伝, 審査, 広告, 微妙, 思惑, 明日, 来週, 無料, 理由, 登録, 結果, 続き, 話題, 軍資金, 運用, 面接, 駄目,

VPSを解約してその処理をレンタルサーバーで行いたいですよね~

2025.11.18

おはようございます.今日から寒くなるそうです、これを書いている時はぽかぽか陽気の日曜日のお昼に書いています. さて「VPSを解約してその処理をレンタルサーバーで行いたいですよね~」という事ですがもしかしたら動かせる可能性 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

~」, AI, Python, VPS, いま, お昼, ギガ, こと, これ, サーバー, スマホ, そう, ため, とき, プラン, よう, レコメンド, レンタル, わけ, 今日, 先日, 処理, 削減, 動作, 収入, 可能, 固定, 年間, 度合い, 日曜日, 明日, 時間, 最低限, 殆ど, 節約, 見直し, 解約, 言語, 通信, 陽気,

人って変なもので何もしないのも辛いだと思うですよ.

2025.11.17

おはようございます.「人って変なもので何もしないのも辛いだと思うですよ」、ぷーになって一ヶ月まだ2週間とちょっとだけど、お金にもならないのに何かコードを書いたりしている.これをせずに何もしない状態になると漠然とした将来へ […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

AI, お金, ヶ月, コード, こと, コメント, これ, そう, それ, プロトタイプ, メンタル, もの, よう, 一言, 不安, 人材, 今回, 仕事, 保有, 先日, 匿名, 将来, 意見, 技術, 投資, 早急, 明日, 昨今, 業界, 比率, 状態, 現金, 皆さん, 米国, 脅威, 自分, 転職, 週間, 進化, 関係, 限り, 限界,

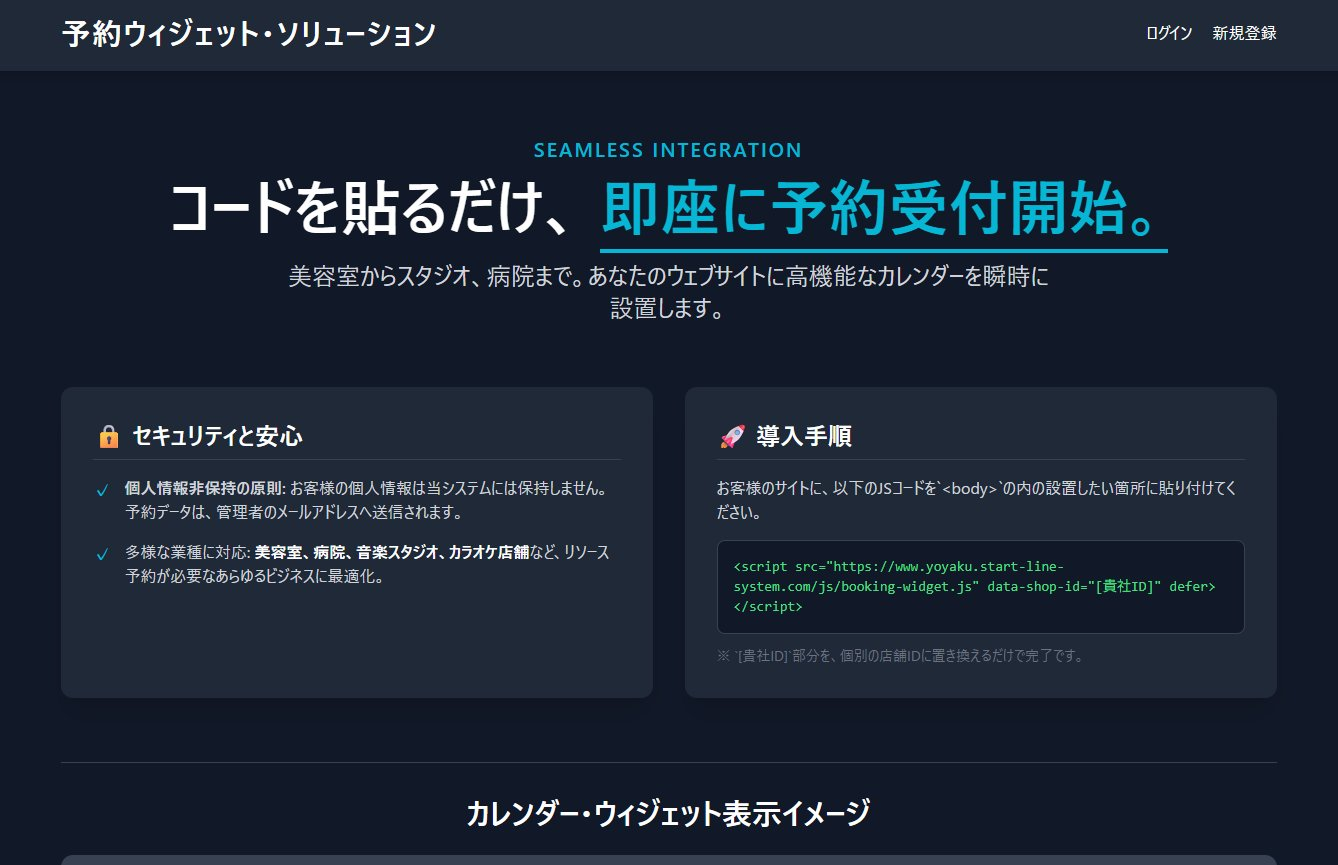

コードを貼るだけで予約機能が追加するやつを提供?.

2025.11.16

おはようございます.コードを貼るだけでサイトに予約機能が追加するやつを提供するか検討している、機能は全て出来上がった感じなのだけど、さてこれどうやって収益化するかという問題があるのだけど、その答えがまだ出ていない. 元々 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

コード, これ, サービス, サイト, チェック, とき, ドメイン, フォーム, やつ, リリース, 予約, 仕様, 仕組み, 他社, 使用, 停止, 全て, 動き, 印象, 参照, 収益, 問題, 広告, 後戻り, 微妙, 感じ, 掲載, 提供, 明日, 普通, 検討, 機能, 確認, 競合, 答え, 自分, 表示, 訪問, 追加, 遷移,

制限付きのクロンを無限寿限無にする方法改正版

2025.11.15

おはようございます.以前作ったコードを改修して、いまの自分が書いたらどうなるのだろうかと思って書いたコードをQiitaとGithubにアップしました.書いてみて思ったのは、やはりコードは書けば書くほど進化していくのだなと […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

AI, github, https, qiita, zipcomebeebbedeaeeafeadebeeaeeafbfeeaeabeebebebephpeahtml, アップ, いま, お墨付き, コード, こちら, こと, これ, コレ, ソース, そう, ため, よう, 今回, 今後, 仕事, 以前, 使用, 典型, 完璧, 改修, 明日, 毎日, 洗練, 精進, 自分, 記事, 進化, 過去,

相手が自分のことを知っていて自分は知らない事が多いパターン

2025.11.13

おはようございます.面識がないけど自分の場合はブログやXで発信しているので、タイトルの状況が出来やすいそしてイメージが出会う前から作られていたりしてたりという場面がある、これは良いこともあれば悪いこともある. 自分の文章 […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

イメージ, こと, これ, スイッチ, それ, タイトル, だんまり, どちら, ネット, ブログ, ほう, まとまり, よう, 冷徹, 同一, 場合, 場面, 好き, 定性的, 感情, 文章, 明日, 機械, 物事, 状況, 発信, 知識, 緊張, 考え, 自分, 面識,

IQが中央値以下は身近にいるだよね…知らんけんど.

2025.11.10

おはようございます.無作為に人を100人集めたら50%のひとがIQが中央値以下になるだよ、知らんけんどという事で学校などはそういう環境にあります、特に義務教育期間中の公立はそんな感じになりますよね. 社会に出るとそうなら […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

AI, IQ, こと, これ, ショット, スクリーン, そこ, ひと, ほう, ょっち, 世の中, 中央, 中学生, 乱暴, 以下, 作為, 公立, 割愛, 大事, 学校, 平均, 年々, 念頭, 情報, 意味, 感じ, 教育, 日々, 明日, 時代, 期間, 本当, 機会, 環境, 社会, 義務, 行動, 衝撃, 表現, 言葉, 識字, 質問, 追伸, 関係, 高校,

観ずになりそうな映画、その壱その弐

2025.11.09

おはようございます.先日は久しぶりに温かな陽気でしたね、今日(2025-11-07)もそんな陽気になりそうです.さて、これを書いているのは金曜日です、いつもなら映画を午前中に観に行っているものですけど、映画を観ずにウォー […]

![]() 著者名

@taoka_toshiaki

著者名

@taoka_toshiaki

※この記事は著者が40代後半に書いたものです.

Profile

高知県在住の@taoka_toshiakiです、記事を読んで頂きありがとうございます.

数十年前から息を吸うように日々記事を書いてます.たまに休んだりする日もありますがほぼ毎日投稿を心掛けています😅.

SNSも使っています、フォロー、いいね、シェア宜しくお願い致します🙇.

SNS::@taoka_toshiaki

タグ

TOHO, あと, アバター, ウォーキング, こと, これ, シネマズ, スカーレット, そう, だだ, ため, つもり, ところ, どれ, ネトフリ, ハット, プレデター, ポイント, もの, よう, ランド, 久しぶり, 予定, 今年, 今日, 先日, 制度, 削減, 割引, 午前, 失効, 廃止, 感じ, 明日, 映画, 本日, 来年, 残念, 温か, 火曜日, 状態, 経費, 追加, 金曜日, 鑑賞, 陽気,